Что такое Big Data?

Big Data или большие данные — это структурированные или неструктурированные массивы данных большого объема. Их обрабатывают при помощи специальных автоматизированных инструментов, чтобы использовать для статистики, анализа, прогнозов и принятия решений.

Сам термин «большие данные» предложил редактор журнала Nature Клиффорд Линч в спецвыпуске 2008 года [1]. Он говорил о взрывном росте объемов информации в мире. К большим данным Линч отнес любые массивы неоднородных данных более 150 Гб в сутки, однако единого критерия до сих пор не существует.

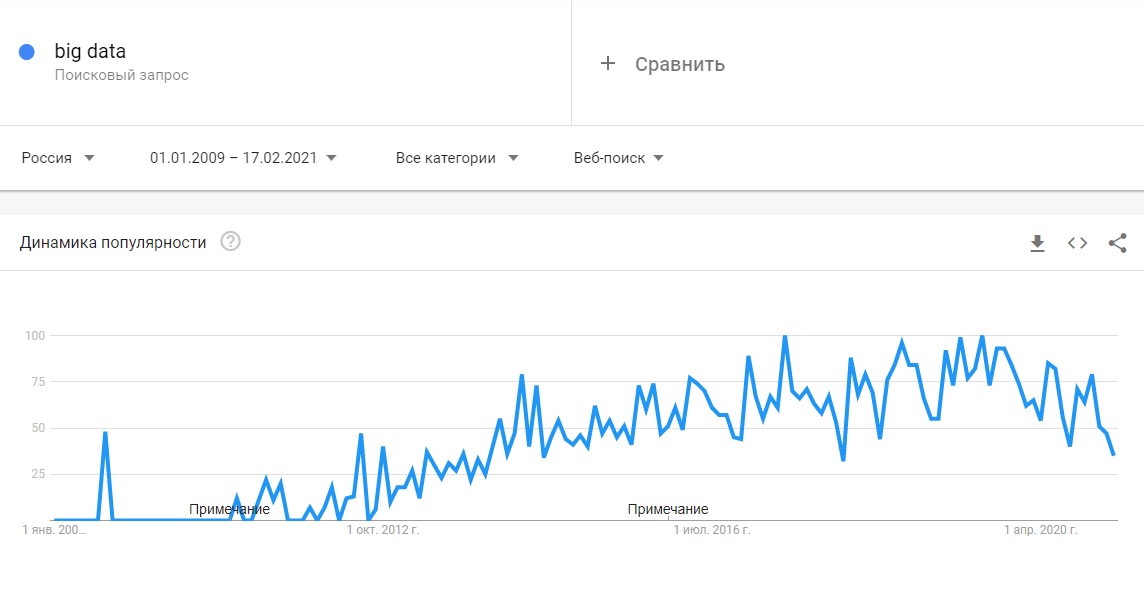

До 2011 года анализом больших данных занимались только в рамках научных и статистических исследований. Но к началу 2012-го объемы данных выросли до огромных масштабов, и возникла потребность в их систематизации и практическом применении.

С 2014 на Big Data обратили внимание ведущие мировые вузы, где обучают прикладным инженерным и IT-специальностям. Затем к сбору и анализу подключились IT-корпорации — такие, как Microsoft, IBM, Oracle, EMC, а затем и Google, Apple, Facebook (с 21 марта 2022 года соцсеть запрещена в России решением суда) и Amazon. Сегодня большие данные используют крупные компании во всех отраслях, а также — госорганы. Подробнее об этом — в материале «Кто и зачем собирает большие данные?»

Какие есть характеристики Big Data?

Компания Meta Group предложила основные характеристики больших данных [2]:

- Volume — объем данных: от 150 Гб в сутки;

- Velocity — скорость накопления и обработки массивов данных. Большие данные обновляются регулярно, поэтому необходимы интеллектуальные технологии для их обработки в режиме онлайн;

- Variety — разнообразие типов данных. Данные могут быть структурированными, неструктурированными или структурированными частично. Например, в соцсетях поток данных не структурирован: это могут быть текстовые посты, фото или видео.

Сегодня к этим трем добавляют еще три признака [3]:

- Veracity — достоверность как самого набора данных, так и результатов его анализа;

- Variability — изменчивость. У потоков данных бывают свои пики и спады под влиянием сезонов или социальных явлений. Чем нестабильнее и изменчивее поток данных, тем сложнее его анализировать;

- Value — ценность или значимость. Как и любая информация, большие данные могут быть простыми или сложными для восприятия и анализа. Пример простых данных — это посты в соцсетях, сложных — банковские транзакции.

Как работает Big Data: как собирают и хранят большие данные?

Большие данные необходимы, чтобы проанализировать все значимые факторы и принять правильное решение. С помощью Big Data строят модели-симуляции, чтобы протестировать то или иное решение, идею, продукт.

Главные источники больших данных:

- интернет вещей (IoT) и подключенные к нему устройства;

- соцсети, блоги и СМИ;

- данные компаний: транзакции, заказы товаров и услуг, поездки на такси и каршеринге, профили клиентов;

- показания приборов: метеорологические станции, измерители состава воздуха и водоемов, данные со спутников;

- статистика городов и государств: данные о перемещениях, рождаемости и смертности;

- медицинские данные: анализы, заболевания, диагностические снимки.

С 2007 года в распоряжении ФБР и ЦРУ появилась PRISM — один из самых продвинутых сервисов, который собирает персональные данные обо всех пользователях соцсетей, а также сервисов Microsoft, Google, Apple, Yahoo и даже записи телефонных разговоров.

Современные вычислительные системы обеспечивают мгновенный доступ к массивам больших данных. Для их хранения используют специальные дата-центры с самыми мощными серверами.

Помимо традиционных, физических серверов используют облачные хранилища, «озера данных» (data lake — хранилища большого объема неструктурированных данных из одного источника) и Hadoop — фреймворк, состоящий из набора утилит для разработки и выполнения программ распределенных вычислений. Для работы с Big Data применяют передовые методы интеграции и управления, а также подготовки данных для аналитики.

Big Data Analytics — как анализируют большие данные?

Благодаря высокопроизводительным технологиям — таким, как грид-вычисления или аналитика в оперативной памяти, компании могут использовать любые объемы больших данных для анализа. Иногда Big Data сначала структурируют, отбирая только те, что нужны для анализа. Все чаще большие данные применяют для задач в рамках расширенной аналитики, включая искусственный интеллект.

Выделяют четыре основных метода анализа Big Data [4]:

1. Описательная аналитика (descriptive analytics) — самая распространенная. Она отвечает на вопрос «Что произошло?», анализирует данные, поступающие в реальном времени, и исторические данные. Главная цель — выяснить причины и закономерности успехов или неудач в той или иной сфере, чтобы использовать эти данные для наиболее эффективных моделей. Для описательной аналитики используют базовые математические функции. Типичный пример — социологические исследования или данные веб-статистики, которые компания получает через Google Analytics.

Антон Мироненков, управляющий директор «X5 Технологии»:

«Есть два больших класса моделей для принятия решений по ценообразованию. Первый отталкивается от рыночных цен на тот или иной товар. Данные о ценниках в других магазинах собираются, анализируются и на их основе по определенным правилам устанавливаются собственные цены.

Второй класс моделей связан с выстраиванием кривой спроса, которая отражает объемы продаж в зависимости от цены. Это более аналитическая история. В онлайне такой механизм применяется очень широко, и мы переносим эту технологию из онлайна в офлайн».

2. Прогнозная или предикативная аналитика (predictive analytics) — помогает спрогнозировать наиболее вероятное развитие событий на основе имеющихся данных. Для этого используют готовые шаблоны на основе каких-либо объектов или явлений с аналогичным набором характеристик. С помощью предикативной (или предиктивной, прогнозной) аналитики можно, например, просчитать обвал или изменение цен на фондовом рынке. Или оценить возможности потенциального заемщика по выплате кредита.

3. Предписательная аналитика (prescriptive analytics) — следующий уровень по сравнению с прогнозной. С помощью Big Data и современных технологий можно выявить проблемные точки в бизнесе или любой другой деятельности и рассчитать, при каком сценарии их можно избежать их в будущем.

Сеть медицинских центров Aurora Health Care ежегодно экономит $6 млн за счет предписывающей аналитики: ей удалось снизить число повторных госпитализаций на 10% [5].

4. Диагностическая аналитика (diagnostic analytics) — использует данные, чтобы проанализировать причины произошедшего. Это помогает выявлять аномалии и случайные связи между событиями и действиями.

Например, Amazon анализирует данные о продажах и валовой прибыли для различных продуктов, чтобы выяснить, почему они принесли меньше дохода, чем ожидалось.

Данные обрабатывают и анализируют с помощью различных инструментов и технологий [6] [7]:

- Cпециальное ПО: NoSQL, MapReduce, Hadoop, R;

- Data mining — извлечение из массивов ранее неизвестных данных с помощью большого набора техник;

- ИИ и нейросети — для построения моделей на основе Big Data, включая распознавание текста и изображений. Например, оператор лотерей «Столото» сделал большие данные основой своей стратегии в рамках Data-driven Organization. С помощью Big Data и искусственного интеллекта компания анализирует клиентский опыт и предлагает персонифицированные продукты и сервисы;

- Визуализация аналитических данных — анимированные модели или графики, созданные на основе больших данных.

Как отметил в подкасте РБК Трендов менеджер по развитию IoT «Яндекс.Облака» Александр Сурков, разработчики придерживаются двух критериев сбора информации:

- Обезличивание данных делает персональную информацию пользователей в какой-то степени недоступной;

- Агрегированность данных позволяет оперировать лишь со средними показателями.

Чтобы обрабатывать большие массивы данных в режиме онлайн используют суперкомпьютеры: их мощность и вычислительные возможности многократно превосходят обычные. Подробнее — в материале «Как устроены суперкомпьютеры и что они умеют».

Big Data и Data Science — в чем разница?

Data Science или наука о данных — это сфера деятельности, которая подразумевает сбор, обработку и анализ данных, — структурированных и неструктурированных, не только больших. В ней используют методы математического и статистического анализа, а также программные решения. Data Science работает, в том числе, и с Big Data, но ее главная цель — найти в данных что-то ценное, чтобы использовать это для конкретных задач.

В каких отраслях уже используют Big Data?

- Государственное управление. Изучение и анализ больших данных помогает правительствам принимать решения в таких областях, как здравоохранение, занятость населения, экономическое регулирование, борьба с преступностью и обеспечение безопасности, реагирование на чрезвычайные ситуации;

- Промышленность. Внедрение инструментов Big Data помогает повысить прозрачность промышленных процессов и внедрять «предиктивное производство», позволяющее более точно прогнозировать спрос на продукцию и, соответственно, планировать расходование ресурсов;

- Медицина. Огромное количество данных, собираемых медицинскими учреждениями и различными электронными приспособлениями (фитнес-браслетами и т.п.) открывает принципиально новые возможности перед индустрией здравоохранения. Большие данные помогают находить новые лекарства, точнее ставить диагнозы, подбирать эффективное лечение, бороться с пандемий;

- Ретейл. Развитие сетевой и электронной торговли невозможно представить без основанных на Big Data решениях — так магазины персонализируют ассортимент и доставку;

- Интернет вещей. Big Data и интернет вещей неразрывно связаны между собой. Промышленные и бытовые приборы, подключенные к интернету вещей, собирают огромное количество данных, на основе анализа которых впоследствии регулируется работа этих приборов;

- Рынок недвижимости. Девелоперы используют технологии Big Data, чтобы собрать и проанализировать весь массив информации, а затем выдать пользователю наиболее интересные для него варианты. Уже сейчас будущий покупатель может посмотреть понравившийся дом без продавца;

- Спорт. С помощью больших данных футбольные клубы отбирают самых перспективных игроков и разрабатывают эффективную стратегию для каждого противника.

Выпуск «Индустрии 4.0» о том, как используют Big Data в футболе

- Сельское хозяйство.

«IoT-решение из области так называемого точного земледелия — это когда специальные метеостанции, которые стоят в полях, с помощью сенсоров собирают данные (температура, влажность) и с помощью передающих радио-GSM-модулей отправляют их на IoT-платформу. На ней посредством алгоритмов big data происходит обработка собранной с сенсоров информации и строится высокоточный почасовой прогноз погоды. Клиент видит его в интерфейсе на компьютере, планшете или смартфоне и может оперативно принимать решения», — прокомментировали в «МегаФоне».

Подробнее — в материале «Умные» комбайны и дроны-геологи: как цифровизация меняет экономику».

Big Data в России и мире

По данным компании IBS [8], в 2012 году объем хранящихся в мире цифровых данных вырос на 50%: с 1,8 до 2,7 Збайт (2,7 трлн Гбайт). В 2015-м в мире каждые десять минут генерировалось столько же данных, сколько за весь 2003 год.

По данным компании NetApp, к 2003 году в мире накопилось 5 Эбайтов данных (1 Эбайт = 1 млрд Гбайт). В 2015-м — более 6,5 Збайта, причем тогда большие данные использовали лишь 17% компаний по всему миру [9]. Большую часть данных будут генерировать сами компании, а не их клиенты. При этом обычный пользователь будет коммуницировать с различными устройствами, которые генерируют данные, около 4 800 раз в день.

Первыми Big Data еще пять лет назад начали использовать в ИТ, телекоме и банках. Именно в этих сферах скапливается большой объем данных о транзакциях, геолокации, поисковых запросах и профилях в Сети. В 2019 году прибыль от использования больших данных оценивались в $189 млрд [10] — на 12% больше, чем в 2018-м, при этом к 2022 году она ежегодно будет удваиваться.

Сейчас в США с большими данными работает более 55% компаний [11], в Европе и Азии — около 53%. Только за последние пять лет распространение Big Data в бизнесе выросло в три раза.

Мировыми лидерами по сбору и анализу больших данных являются США и Китай. Так, в США еще при Бараке Обаме правительство запустило шесть федеральных программ по развитию больших данных на общую сумму $200 млн. Главными потребителями Big Data считаются крупные корпорации, однако их деятельность по сбору данных ограничена в некоторых штатах — например, в Калифорнии.

В Китае действует более 200 законов и правил, касающихся защиты личной информации. С 2019 года все популярные приложения для смартфонов начали проверять и блокировать, если они собирают данные о пользователях вопреки законам. В итоге данные через местные сервисы собирает государство, и многие из них недоступны извне.

С 2018 года в Евросоюзе действует GDPR — Всеобщий регламент по защите данных. Он регулирует все, что касается сбора, хранения и использования данных онлайн-пользователей. Когда закон вступил в силу год назад, он считался самой жесткой в мире системой защиты конфиденциальности людей в Интернете.

Подробнее — в материале «Цифровые войны: как искусственный интеллект и большие данные правят миром».

В России рынок больших данных только зарождается. К примеру, сотовые операторы делятся с банками информацией о потенциальных заемщиках [12]. Среди корпораций, которые собирают и анализируют данные — «Яндекс», «Сбер», Mail.ru. Появились специальные инструменты, которые помогают бизнесу собирать и анализировать Big Data — такие, как российский сервис Ctrl2GO.

Big Data в бизнесе

Большие данные полезны для бизнеса в трех главных направлениях:

- Запуск продуктов и сервисов, которые точнее всего «выстрелят» по потребностям целевой аудитории;

- Анализ клиентского опыта в отношении продукта или услуги, чтобы улучшить их;

- Привлечение и удержание клиентов с помощью аналитики.

Большие данные помогают MasterCard предотвращать мошеннические операции со счетами клиентов на сумму более $3 млрд в год [13]. Они позволяют рекламодателям эффективнее распределять бюджеты и размещать рекламу, которая нацелена на самых разных потребителей.

Крупные компании — такие, как Netflix, Procter & Gamble или Coca-Cola — с помощью больших данных прогнозируют потребительский спрос. 70% решений в бизнесе и госуправлении принимается на основе геоданных. Подробнее — в материале о том, как бизнес извлекает прибыль из Big Data.

Каковы проблемы и перспективы Big Data?

Главные проблемы:

- Большие данные неоднородны, поэтому их сложно обрабатывать для статистических выводов. Чем больше требуется параметров для прогнозирования, тем больше ошибок накапливается при анализе;

- Для работы с большими массивами данных онлайн нужны огромные вычислительные мощности. Такие ресурсы обходятся очень дорого, и пока что доступны только большим корпорациям;

- Хранение и обработка Big Data связаны с повышенной уязвимостью для кибератак и всевозможных утечек. Яркий пример — скандалы с профилями Facebook;

- Сбор больших данных часто связан с проблемой приватности: не все хотят, чтобы каждое их действие отслеживали и передавали третьим лицам. Герои подкаста «Что изменилось» объясняют, почему конфиденциальности в Сети больше нет, и технологическим гигантам известно о нас все;

- Большие данные используют в своих целях не только корпорации, но и политики: например, чтобы повлиять на выборы.

Плюсы и перспективы:

- Большие данные помогают решать глобальные проблемы — например, бороться с пандемией, находить лекарства от рака и предотвращать экологический кризис;

- Big Data — хороший инструмент для создания умных городов и решения проблемы транспорта;

- Большие данные помогают экономить средства даже на государственном уровне: например, в Германии вернули в бюджет около €15 млрд [14], обнаружив, что часть граждан получают пособие по безработице без всяких оснований. Их вычислили с помощью транзакций.

В ближайшем будущем большие данные станут главным инструментом для принятия решений — начиная с сетевых бизнесов и заканчивая целыми государствами и международными организациями [15].

Главное о Big Data

- Big Data (большие данные) — это огромные массивы структурированных и неструктурированных данных от 150 Гб/сутки, которые обрабатываются специальными инструментами для анализа, прогнозирования и принятия решений.

- Ключевые характеристики: объем (Volume), скорость обработки (Velocity), разнообразие (Variety), достоверность (Veracity), изменчивость (Variability) и ценность (Value).

- Основные источники: интернет вещей (IoT), социальные сети, корпоративные данные, показания приборов, государственная и медицинская статистика.

- Главные методы анализа: описательная, прогнозная, предписательная и диагностическая аналитика с использованием ПО (Hadoop, NoSQL), data mining и ИИ.

- Применение в отраслях: госуправление, промышленность, медицина, ритейл, IoT, недвижимость, спорт и сельское хозяйство для оптимизации процессов и прогнозирования.

- Мировые лидеры: США и Китай, где сбор данных регулируется законами (GDPR в ЕС, локальные нормы в Калифорнии и Китае).

- Польза для бизнеса: запуск перспективных продуктов, анализ клиентского опыта, привлечение и удержание клиентов, борьба с мошенничеством.

- Проблемы: неоднородность данных, дорогие вычислительные мощности, уязвимость к кибератакам, вопросы приватности и политические манипуляции.

- Перспективы: решение глобальных проблем (пандемии, экология), создание умных городов, оптимизация госрасходов и переход к data-driven принятию решений.

- Российский рынок развивается: данные используют «Яндекс», «Сбер», операторы; появляются локальные инструменты вроде Ctrl2GO.