Несмотря на то, что некоторые модели искусственного интеллекта уже умеют общаться практически как люди и генерировать картины, которые побеждают в конкурсах, исследователям еще не удалось создать универсальный ИИ, способный выполнять все эти задачи одновременно и при этом качественно. РБК Тренды рассказывают, в чем тонкости обучения нейросетей и с какими сложностями сталкиваются разработчики универсального ИИ.

Стадии развития искусственного интеллекта

Старший научный сотрудник Института проблем информационной безопасности МГУ Евгений Ильюшин для оценки уровня развития ИИ использует кривую Гартнера. Кривая Гартнера — это фаза зрелости технологического проекта, которая включает в себя пять этапов для любой разработки или технологии: запуск, достижение наивысших ожиданий, спад ожиданий, появление новых надежд и плато продуктивного роста. По оценкам Ильюшина, сфера ИИ находится между предпоследним и последним этапами.

«В последние годы мы наблюдали некоторый спад в интересах и ожиданиях от ИИ. Но в том числе из-за критики существующих подходов появились новые области, которые позволяют алгоритмам развиваться. Ученые все глубже стараются понять принципы работы искусственного интеллекта, и это необходимо для внедрения ИИ в нашу жизнь. Технологии добились серьезной зрелости: их можно включать в критически важные системы. Но прежде чем мы начнем это сделать массово, мы должны получить механизмы оценки устойчивости алгоритмов», — отмечает Ильюшин.

Нейросети-трансформеры

В развитии ИИ особую роль играет архитектура, на которой строятся нейросети. По словам ведущего специалиста Новосибирского госуниверситета, основателя проекта Aigents по созданию персонального искусственного интеллекта, архитектора децентрализованной ИИ-платформы SingularityNET, эксперта Российского совета по международным делам Антона Колонина, сфера искусственного интеллекта находится на подъеме и демонстрирует все более впечатляющие результаты благодаря внедрению нового типа нейросетевой архитектуры — трансформера.

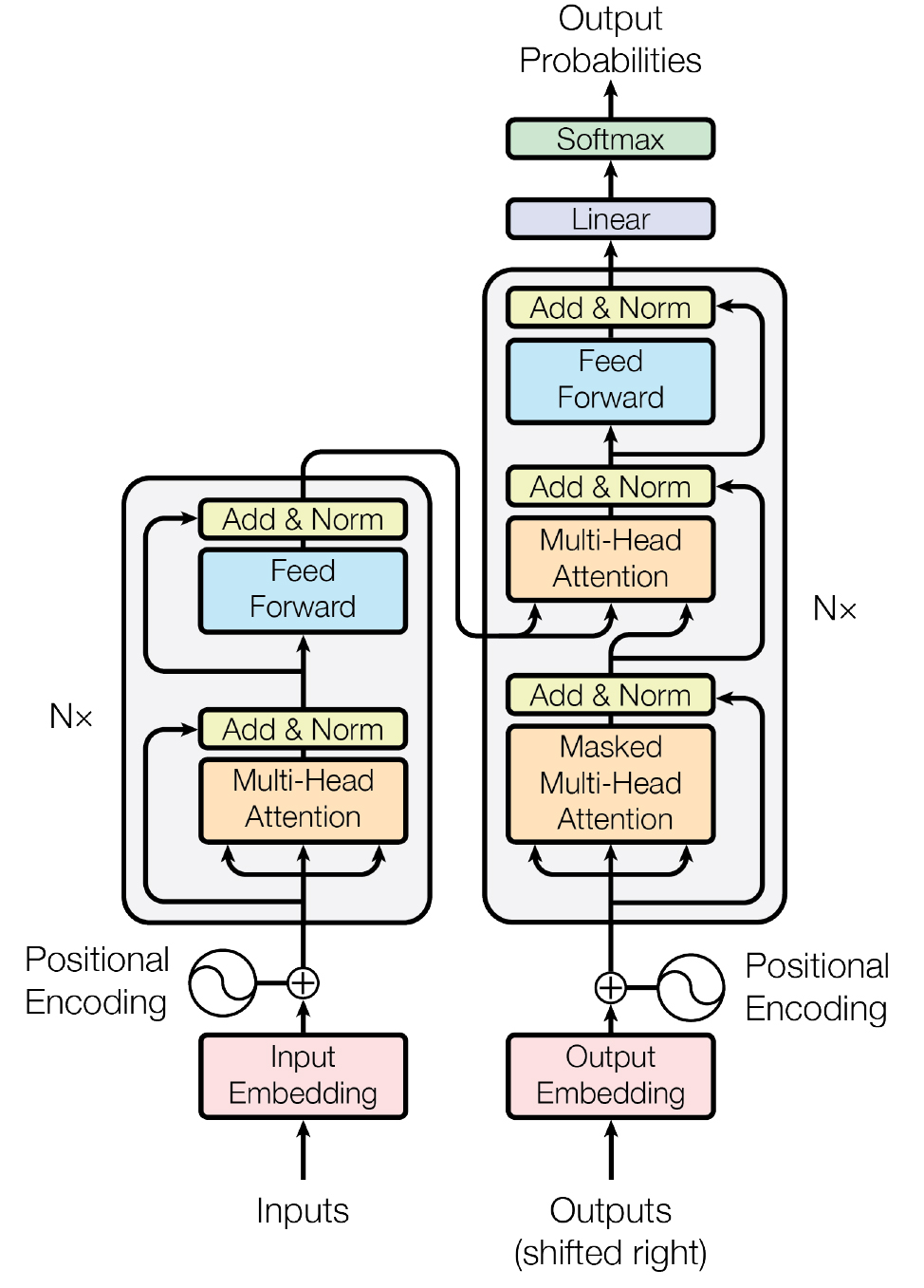

Трансформеры — это тип нейросетей, который направлен на решение последовательностей с обработкой зависимостей. Таким образом, трансформеры не обрабатывают последовательности по порядку — они способны сразу фокусироваться на необходимых элементах данных благодаря «механизму внимания». Этот же механизм позволяет трансформеру выбирать подходящий ответ исходя из контекста входной информации, например, для слов-синонимов. Это позволяет увеличить скорость обучения такой нейросети.

Основными компонентами трансформеров выступают энкодер и декодер. Первый преобразовывает входящую информацию (например, текст) и конвертирует ее в вектор (набор чисел). Второй расшифровывает вектор в виде новой последовательности (например, ответ на вопрос), но уже из слов на другом языке.

Колонин отмечает, что подвижки в обучении нейросетей связаны с включением в него миллиардов параметров. Это позволяют строить очень сложные сети на основе архитектур трансформеров. В качестве примеров эксперт приводит алгоритмы обработки естественного языка Google BERT (обучен на всех текстах Wikipedia и Book Corpus), а также GPT-3 от OpenAI (обучен на 175 млрд параметров).

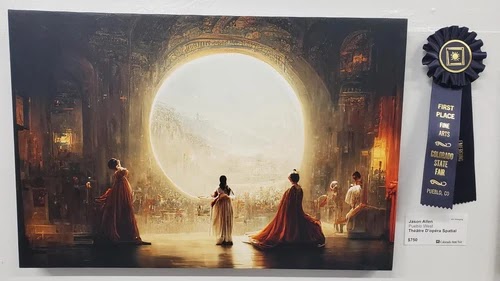

Наряду с увеличением числа параметров производится мультимодальное обучение систем на разнородных данных, например, не только на текстах, но и на текстах с картинками. В качестве примера эксперт приводит картину американца Джейсона Аллена, созданную алгоритмом Midjourney, которая победила в ежегодном конкурсе художников в Колорадо. Этот алгоритм создает картину по текстовому описанию.

По словам Колонина, современные глубокие нейронные сети имеют иерархическую природу. Это свойство 5-10 лет назад дало возможность ученым начать использовать их «глубину» для построения моделей в различных предметных областях. На самых нижних слоях этих сетей находится первичная информация, где каждый искусственный нейрон связан с отдельным ее элементом (в случае с картинками это пиксели). На самом верхнем уровне находятся понятия. Если стоит задача отличать котов от собак, то на верхнем слое будет два искусственных нейрона, каждый из которых отвечает за определенное животное. Промежуточные слои нейросети будут отмечать текстуру шерсти, количество лап, цвет глаз, форму ушей.

Нейросети-трансформеры быстро вошли в область обработки естественного языка. В России их использует в своих сервисах, например, «Яндекс».

Впоследствии выяснилось, что такие модели могут решать и другие задачи, например, классифицировать части речи в тексте, выявлять «настроение» текста и т.д., говорит эксперт. В настоящее время сфера применения трансформеров расширяется — их используют для генерации изображений (алгоритмы DALL-E, Midjourney) или в биотехнологиях (система для предсказания структур белка AlphaFold).

Проблемы обучения нейросетей

Алгоритмы глубокого обучения имитируют человеческий мозг с помощью искусственных нейронных сетей и постепенно учатся точно решать поставленную задачу. Но в системах глубокого обучения ИИ присутствуют серьезные проблемы.

Исследователи в области глубокого обучения выделяют следующие проблемы:

- слишком большой объем данных. Чем более мощную нейросеть требуется обучить, тем больше параметров необходимо настроить, а каждый из них включает в себя огромные массивы информации. Например, программе распознавания речи потребуются терабайты данных для изучения одного языка. Правда, группа исследователей из Microsoft и Гарвардского университета уже пытается решить эту проблему. Исследователи разработали архитектуру нейросети, при обучении которой можно сократить количество параметров до константы, даже если сеть состоит из триллионов узлов. Исследование демонстрирует, что простая архитектура нейросети может обучаться так же хорошо, как любой алгоритм для выборки ограниченного размера;

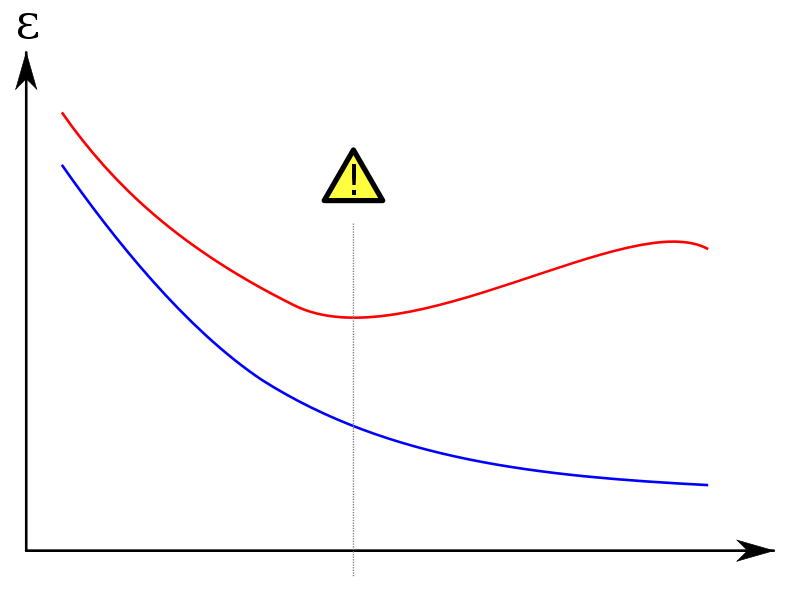

- сложность переобучения. Если в видимых наборах данных есть ошибка, то сложная модель будет генерировать ее уже в собственных данных;

- оптимизация гиперпараметров — параметров, значение которых определяется до начала процесса обучения. Изменение значения таких параметров на небольшую величину может привести к значительному изменению производительности модели;

- потребность в высокопроизводительном оборудовании. Чтобы повысить эффективность и сократить затраты времени, специалисты по обработке и анализу данных переходят на высокопроизводительные графические процессоры, но они дорого стоят и потребляют много энергии;

- проблема «черного ящика». Исследователи знают параметры модели, но не всегда понимают, как нейросети приходят к тому или иному решению. Из-за этого они могут выдавать ложные утверждения и даже использоваться во вред, как это было в экспериментах с GPT-3;

- отсутствие гибкости и многозадачности. Модели глубокого обучения могут обеспечить чрезвычайно эффективное и точное решение конкретной проблемы, но пока архитектуры узкоспециализированы для конкретных областей применения.

Ведущий научный сотрудник лаборатории аналитики потоковых данных и машинного обучения Новосибирского госуниверситета Евгений Павловский считает, что один из способов упростить «учебный» процесс нейросети — применить полуконтролируемое обучение. По его словам, при таком методе данные не нужно размечать, а алгоритм учится самостоятельно, определяя структуру текста и изображения. С помощью такого метода обучали GPT-3. «Есть метод маскирования, когда мы удаляем слово, а алгоритм пытается предсказать его по соседним словам. На основе него строится модель предсказания. Алгоритм сам себя оценивает, хорошую он модель построил или нет. Если ему дать грамотный текст, то он не только выучит сам текст, но усвоит понятие грамотности и станет способен правильно расставлять знаки препинания», — рассказывает эксперт.

Например, ученые из Массачусетского технологического института, Корнеллского университета и Университета Макгилла продемонстрировали ИИ-систему, которая научилась самостоятельно изучать правила и закономерности человеческого языка. система способна объяснить, почему слово поменяло свою форму в зависимости от пола, времени или падежа. Исследователи обучили модель, используя задачи из учебников по лингвистике на 58 различных языках.

По словам Евгения Ильюшина, сейчас важной стала задача генерации синтетических данных, которые используются в бизнес-приложениях и для создания обучающих ИИ датасетов. Одна из перспектив — это улучшение таких архитектур до получения порождающих состязательных сетей. Идея заключается в том, что берутся две нейросетевые модели, одна — генератор, она создает синтетические данные, очень похожие на реальные, вторая — дискриминатор, она учится отличать их от реальных. В ходе обучения генератор пытается «обмануть» дискриминатор. В процессе состязания обучается модель, которая способна порождать синтетические данные, которые человеку очень сложно, а иногда и вовсе невозможно отличить от реальных.

Как отмечает Ильюшин, иногда данных недостаточно. В этом случае можно использовать метаобучение по малым выборкам: алгоритм на основе предыдущего опыта самостоятельно адаптирует процесс обучения в зависимости от конкретной стоящей перед ним задачи. В области обработки естественного языка часто используют многозадачное обучение, при котором алгоритм получает несколько заданий параллельно, а результаты работы влияют друг на друга. Проверка моделей проходит по нескольким задачам, для каждой из которых должно быть достигнуто требуемое качество.

Антон Колонин считает одним из направлений, которое позволяет оптимизировать и ускорить процесс обучения, метод curriculum learning — стратегию, которая обучает модель, начиная от более простых данных и переходя к более сложным, что имитирует осмысленный порядок обучения по типу человеческого.

По словам Евгения Павловского, благодаря развитию вычислительных технологий за последние годы скорость обучения нейросетей значительно выросла. Крупные корпорации выпускают тензорные процессоры, которые адаптированы под машинное обучение нейросетей. Однако, по его словам, еще быстрее будут работать квантовые процессоры.

«От квантовых процессов ожидается высокая скорость вычислений. Они оперируют кубитами, которые имеют принципиально другую природу, нежели классические биты. Ожидания того, что они быстрее, доказано разными теоремами. С помощью квантовых процессоров должно ускориться обучение алгоритмов искусственного интеллекта. Квантовое машинное обучение может не только быть быстрее само по себе, но и в принципе менять постановку задачи за счет работы с неопределенностью, получать пространства, в которых решения упрощаются. Кроме того, для этого вида обучения нужны достаточно малые выборки данных — недавно исследование, подтверждающее эту гипотезу, вышло в журнале Nature», — рассказывает ученый.

Антон Колонин отмечает, что проблема неинтерпретируемости систем ИИ остается актуальной. «Модели, которые отличают одни объекты от других — неинтерпретируемые. Мы можем научиться отличать кошек от собак, и это работает в 99% случаев хорошо, а за 1% никто не переживает, это не критическая задача. Но если нам надо управлять энергетическими сетями, диагностировать заболевания или применять ИИ в военной сфере, то здесь даже 8-10% ошибок — это много. Нам нужно как минимум иметь возможность заглянуть обученной системе в «мозг» и узнать, чему она научилась, прежде чем направлять ее оперировать пациентов, контролировать атомную станцию или ставить на боевое дежурство. Нам надо убедиться, что она знает правильные вещи и случайно не научилась чему-то лишнему или что-то недоучила. Это в идеале, но, как минимум, если она приняла какое-то решение, то должна объяснить, почему его приняла», — говорит эксперт.

Универсальный искусственный интеллект

Алгоритмы, которые распознают образы или тексты, относят к узкоспециализированным. Однако перед исследователями стоит более серьезная задача — создать общий или универсальный искусственный интеллект (Artificial General Intellegence, AGI).

Некоторые группы исследователей занимаются разработкой моделей глубокого обучения, которые могут работать на прежней архитектуре, но в многозадачном режиме. Они уже наблюдают значительный прогресс в многозадачном обучении (MTL). Так, исследователи из команды Google Brain Team и Университета Торонто представили доклад о MultiModel, архитектуре нейронной сети, основанной на успехе зрительных, языковых и аудиосетей, которая может распознавать изображения и речь, переводить с одного языка на другой.

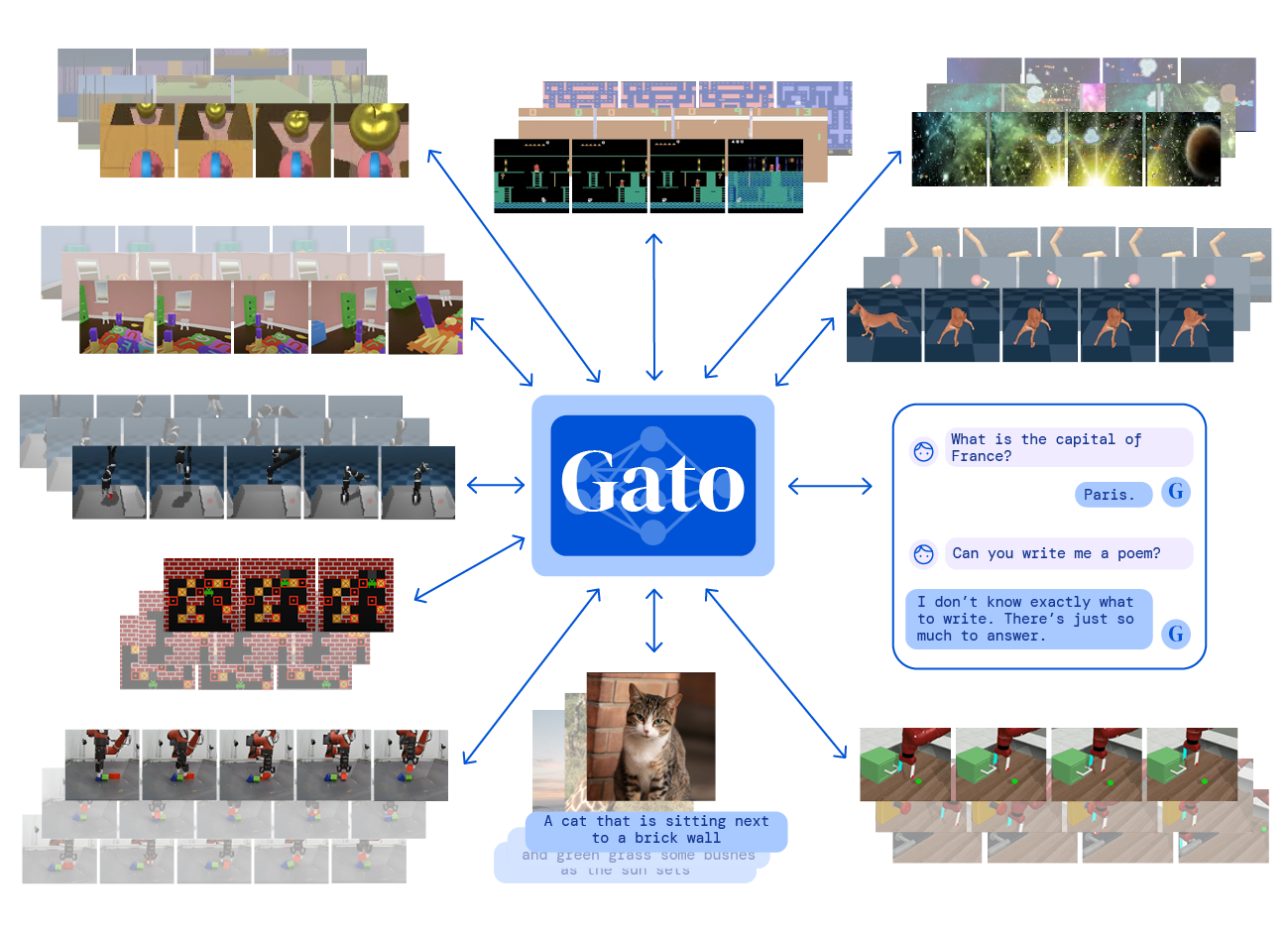

А британская компания DeepMind представила систему искусственного интеллекта «общего назначения» под названием Gato, которую обучили выполнять 604 разных задания, в том числе добавлять подписи к изображениям, участвовать в диалогах, складывать блоки с помощью роборуки и играть в игры Atari. Gato обучили на примерах миллиардов слов, изображений из реального мира и смоделированных сред. С архитектурной точки зрения это нейросеть-трансформер по типу GPT-3. Однако у Gato всего 1,2 млрд параметров, тогда как у GPT-3 — более 170 млрд. DeepMind утверждает, что в 450 из 604 вышеупомянутых задач модель работает лучше, чем человек-эксперт.

Антон Колонин, который 25 лет занимается исследованиями в области AGI, отмечает, что до сих пор нет единого мнения, что должен представлять собой общий искусственный интеллект. «Одни считают, что эта система по своим интеллектуальным способностям должна быть как человек. Другие — что это технология, которая адаптируется к любым условиям: если ее поместить в человеческую среду, она станет как человек, если в кошачью — как кошка, в кольцо астероидов — она научится буксировать их на Землю и извлекать полезные ископаемые. Третьи полагают, что AGI — просто некоторая технология, которая позволяет для любых задач быстро создавать прикладные интеллектуальные решения», — говорит он.

Часть ученых считают, что для воспроизведения в AGI человеческого интеллекта нужно сперва выяснить, как этот интеллект работает. Другие исследователи уверены, что разбираться в деталях устройства разумного поведения и мышления необязательно, якобы можно понять их основные принципы и воспроизвести в компьютерных моделях без оглядки на нейрофизиологию, поясняет Колонин.

Однако уже есть несколько гипотез на тему того, как создавать AGI. Первая заключается в том, что надо строить большие нейросети и объединять их друг с другом разными способами. Суть второй состоит в том, что нейросети в чистом виде — это тупиковое направление, и нужны математические методы, основанные на вероятностной логике. Сторонники третьей гипотезы полагают, что нужно сочетать и современные методы обучения глубоких нейросетей, и формальные математические методы.