Ожидается, что в 2025 году мировой рынок искусственного интеллекта вырастет с $184 млрд до $244 млрд. Аналитики Deloitte ожидают, что к 2025 году 25% предприятий будут использовать ИИ-агентов, а более 30% всех смартфонов и 50% ноутбуков будут поддерживать функции генеративного ИИ. Первого такого ИИ-агента в 2024 году представила компания Anthropic, чья модель Claude 3.5 Sonnet может автономно управлять компьютером. «РБК Тренды» рассказывают, какие разработки ИИ готовятся представить компании в следующем году.

GPT-5 и Operator

Ожидается, что в 2025 году OpenAI выпустит новое поколение своей модели GPT-5. Эксперты утверждают, что эта итерация может представлять собой монументальный скачок в возможностях ИИ, фундаментально преобразующий бизнес-операции в различных секторах — от принятия решений на основе данных до гиперперсонализированного маркетинга.

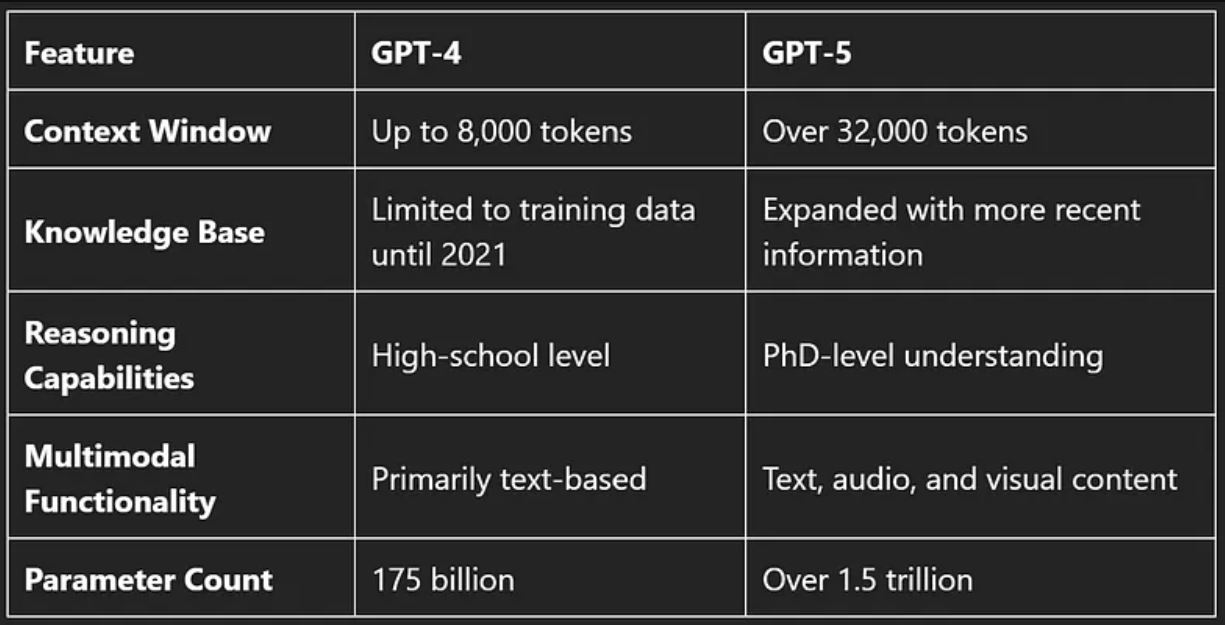

Самым заметным обновлением GPT-5 станет расширение контекстного окна. В то время как GPT-4 может принимать на ввод до 8 тыс. токенов, ожидается, что GPT-5 будет обрабатывать более 32 тыс. токенов и будет иметь более 1,5 трлн параметров. Это позволит модели участвовать в более глубоких беседах, запоминать больше контекста в течение более длительных взаимодействий и синтезировать большие объемы информации. Пользователи смогут загружать в чат-бот сложные документы или исследования, к примеру, из сфер здравоохранения или юриспруденции, чтобы ИИ анализировал их.

Кроме того, GPT-5, как сообщается, будет опираться на более обширную и актуальную базу знаний, включающую в себя больший спектр тем. Это улучшение имеет решающее значение для специалистов из секторов, которые оперируют данными в реальном времени. Например, финансисты смогут непрерывно анализировать рынки, а исследователи получат доступ к новейшей научной литературе.

Прогнозируется, что навыки рассуждения GPT-5 значительно превзойдут GPT-4. Текущая модель демонстрирует средний уровень понимания, тогда как GPT-5 сможет анализировать информацию на «уровне кандидата наук», решать сложные проблемы и рассуждать на продвинутом уровне. Это может произвести революцию в научных исследованиях и конструкторских работах.

Наконец, улучшенные мультимодальные возможности GPT-5 позволят компаниям генерировать не только текстовый, но и аудио- и визуальный контент. Маркетологи смогут создавать гиперперсонализированные, кросс-канальные кампании для отдельных потребителей и активно вовлекать аудиторию, улучшая пользовательский опыт.

OpenAI пообещала при разработке GPT-5 решить ключевые проблемы, связанные с ИИ, в том числе внедрить поддержку водяных знаков для защиты контента, сохранять конфиденциальность данных и смягчить предвзятость модели.

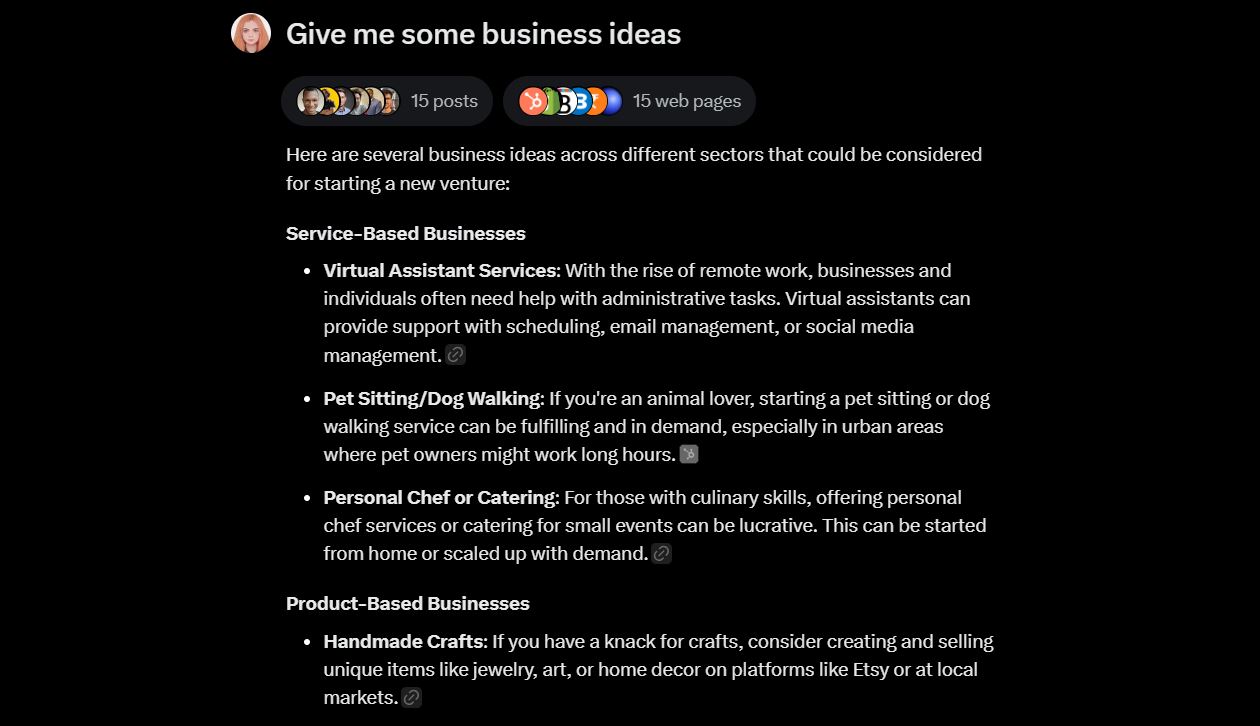

Также главный директор по продуктам OpenAI Кевин Вейл намекал, что в январе 2025 года компания выпустит ИИ-агента под названием Operator. Инструмент предназначен для управления компьютерами и выполнения задач в автономном режиме. Например, он сможет самостоятельно писать код или бронировать поездки. Автономный агент изначально будет доступен через интерфейс прикладного программирования для разработчиков.

Grok 3

Стартап Илона Маска xAI собирается запустить следующее поколение своей большой языковой модели Grok 3 в 2025 году. Предыдущее поколение Grok 2 было представлено в августе 2024 года. Модель продемонстрировала значительные улучшения в рассуждениях, а также научилась правильно дополнять контекст. Осенью в нее добавили также опцию распознавания картинок. В декабре доступ к Grok открыли всем пользователям соцсети Х. В декабре стартап представил также модель генерации изображений с кодовым названием Aurora, которая способна генерировать высококачественные картинки. Особенность модели в том, что она обучена предсказывать следующий токен из чередующихся текстовых и графических данных. Aurora обучили на миллиардах примеров из интернета. Помимо текста модель также имеет встроенную поддержку мультимодального ввода. Маск сообщил, что Aurora, по сути, станет дополнением для существующей модели Grok.

Бизнесмен ранее пообещал, что Grok 3 будет работать на уровне «или выше» GPT-5. Для ее обучения стартап задействует свой новый кластер Colossus из 100 тыс. графических процессоров Nvidia H100, тогда как ее предшественника обучали с использованием мощностей компании Oracle. xAI уже привлекла таких гигантов индустрии, как Nvidia, Dell и Supermicro для создания «гигафабрики вычислений».

Предприниматель отметил, что Grok 3 будет «действительно чем-то особенным».

По словам Маска, в обучении модели также могут задействовать синтетические данные или данные из видео.

Llama 4

Глава Meta (признана экстремистской, ее деятельность запрещена в России) Марк Цукерберг заявил, что компания готовится представить новое поколение больших языковых моделей с открытым исходным кодом Llama 4 в 2025 году. Уже в начале года ожидается выход меньших версий Llama 4. Обновленная модель получит возможность рассуждать, мультимодальный ввод, а также более быстрое время отклика.

Как отметил Цукерберг, Llama 4 будут обучать на кластере графических процессоров, который «больше, чем все существующие» на рынке. Он включает в себя более 100 тыс. ускорителей Nvidia H100. Для сравнения: при разработке Llama 3 использовали около 25 тыс. H100. Цукерберг пояснил, что для обучения Llama 4 компании понадобится в десять раз больше вычислений, чем для Llama 3. По его словам, Meta нацелена за этот счет увеличивать размеры моделей. Так, последняя версия Llama 3.1 405B получила 405 млрд параметров, что сделало ее крупнейшей моделью компании с открытым исходным кодом.

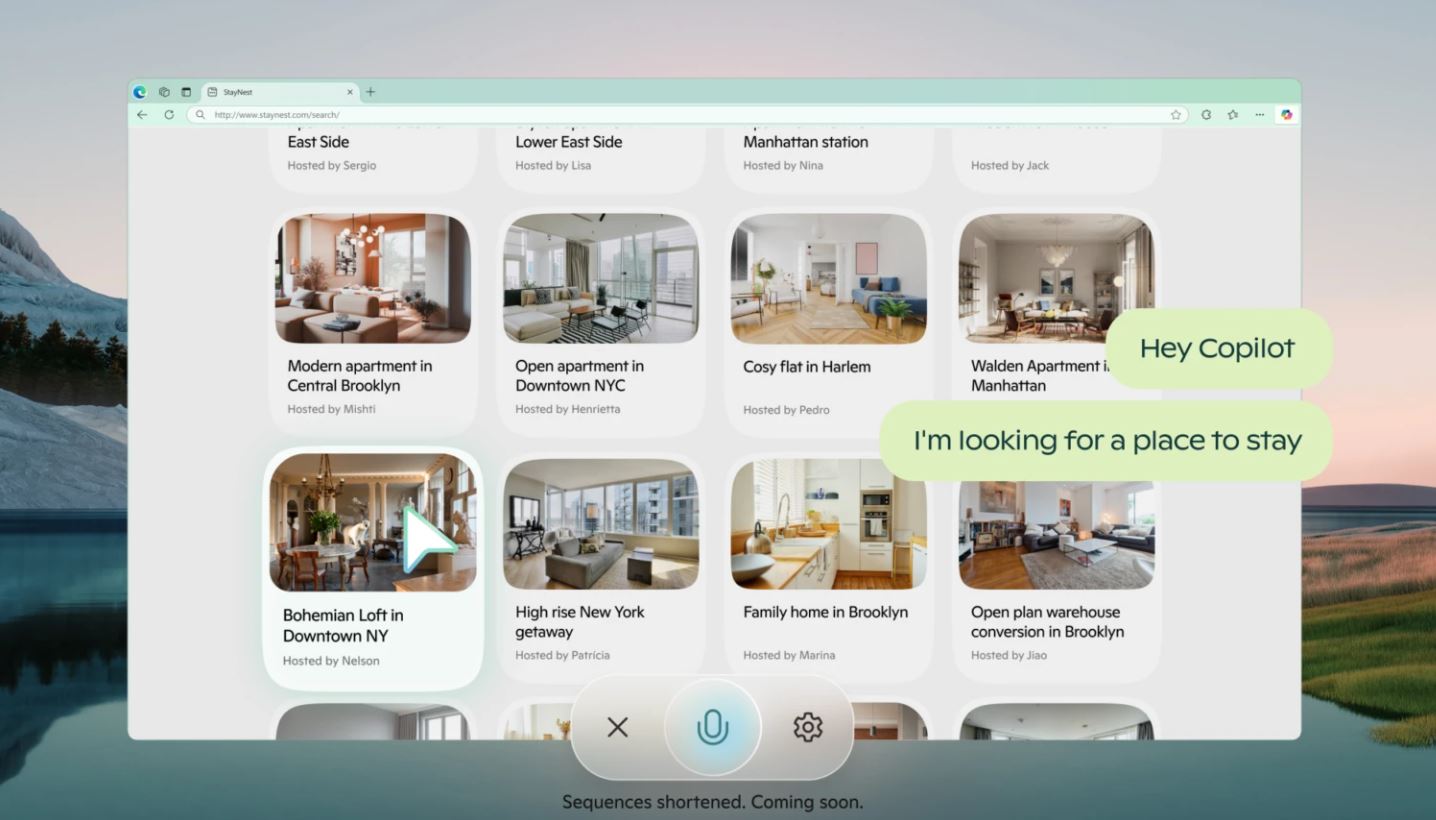

Copilot Vision

В 2025 году ожидается, что Microsoft выпустит новую модель Copilot Vision — ИИ, который будет «понимать, что пользователь делает в Сети». Анализируя действия человека за компьютером, инструмент поможет ему выполнять различные задачи.

Например, пользователь сможет задавать вопросы о веб-странице, а помощник будет искать ответы и предоставлять дополнительную информацию.

Microsoft пообещала уделять первостепенное внимание авторским правам, конфиденциальности и безопасности. Copilot Vision не будет предлагать никакой информации на платных веб-сайтах и не сможет предпринимать действия от имени пользователя. Помощника можно будет включить по желанию. После завершения сеанса он удалит всю информацию о работе.

В октябре Copilot Vision начали тестировать в браузере Microsoft Edge версии Canary, которая предназначена для разработчиков. В декабре компания открыла ограниченный доступ к ИИ для подписчиков своего платного тарифа Copilot Pro в США. Пока помощник работает только в Microsoft Edge и только на определенных веб-сайтах. Однако уже в следующем году круг ресурсов расширят.

Гендиректор Microsoft AI Мустафа Сулейман также рассказал, что в 2025 году компания представит модели ИИ, которые будут иметь «бесконечную» память. Это позволит им поддерживать непрерывное взаимодействие с пользователем.

Project Jarvis

Google тоже не отстает в гонке ИИ и готовится представить свою версию концепции large action model (LAM), подобную той, что разрабатывает компания Rabbit для носимых устройств R1. Модель Project Jarvis сможет выполнять задачи для пользователей, например собирать информацию в интернете, покупать товары или бронировать авиабилеты. Информацию о продукте обнаружили в магазине для разработчиков Chrome.

Основная цель Jarvis — произвести революцию в том, как пользователи взаимодействуют со своими устройствами. Вместо того чтобы служить пассивным инструментом, ожидающим команд, ИИ будет активно участвовать в управлении задачами в реальном времени. Так, помощник может выполнять работу по систематизации документов для юристов или помогать маркетологам со сбором данных для разработки стратегии.

Помимо производительности Jarvis может улучшить доступность веба для широкого круга пользователей. ИИ-помощник будет зачитывать веб-контент вслух или использовать голосовые команды для помощи в навигации.

По данным источников, Project Jarvis будет работать на основе будущей версии Google Gemini и использовать только браузер Chrome. ИИ-помощник будет способен анализировать скриншоты, вводить текст и выполнять действия по поиску всего за «несколько секунд».

Поскольку ИИ будет работать автономно, Google, скорее всего, внедрит усиленное шифрование, строгие ограничения для пользователей и многофакторную аутентификацию для защиты данных.

Изначально компания планирует выпустить инструмент для ограниченного числа тестировщиков, чтобы найти и устранить ошибки в его работе.

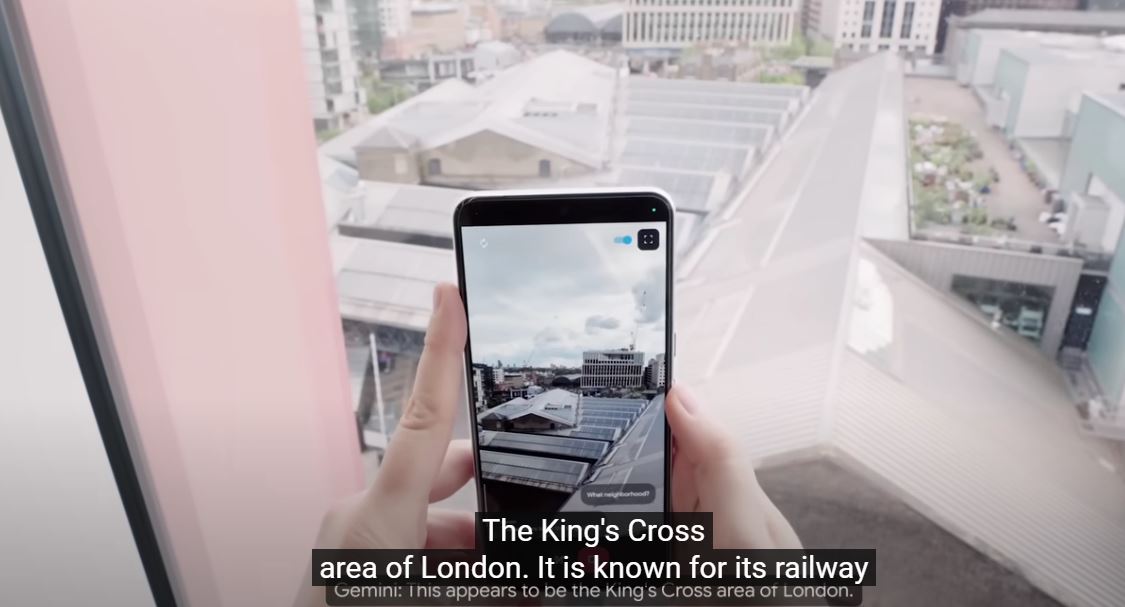

В декабре 2024 года Google уже презентовала поколение моделей Gemini 2, которые включают несколько автономных ИИ-агентов для разных задач — от проведения исследований и до программирования. Также компания продемонстрировала улучшения работы приложения для создания ИИ-агентов Project Astra. Astra использует либо приложение Android, либо прототип очков для записи мира таким, каким его видит человек. Затем инструмент суммирует то, что видит, и отвечает на широкий спектр вопросов, используя ряд сервисов Google, включая «Поиск», «Карты», «Объектив» и Gemini.

Однако Google не будет предлагать технологии из Project Astra рынку до следующего года. Генеральный директор Google Сундар Пичаи заявлял: «Сейчас Google создает опыт, в котором ИИ может видеть и рассуждать о мире вокруг вас. Project Astra — это проблеск такого будущего. Мы работаем над тем, чтобы предоставить новые возможности уже в 2025 году».

Project Astra, который Google продемонстрировала на своей конференции разработчиков I/O в мае 2024 года, охватывает ряд технологий: от приложений для смартфонов, которые могут распознавать окружающий мир и отвечать на соответствующие вопросы, до помощников ИИ, которые могут выполнять действия от имени пользователя. В предварительно записанной демонстрации во время I/O Google показала прототип Project Astra, отвечающий на вопросы о вещах в поле зрения камеры смартфона, например, в каком районе может находиться пользователь или как называется деталь сломанного велосипеда.

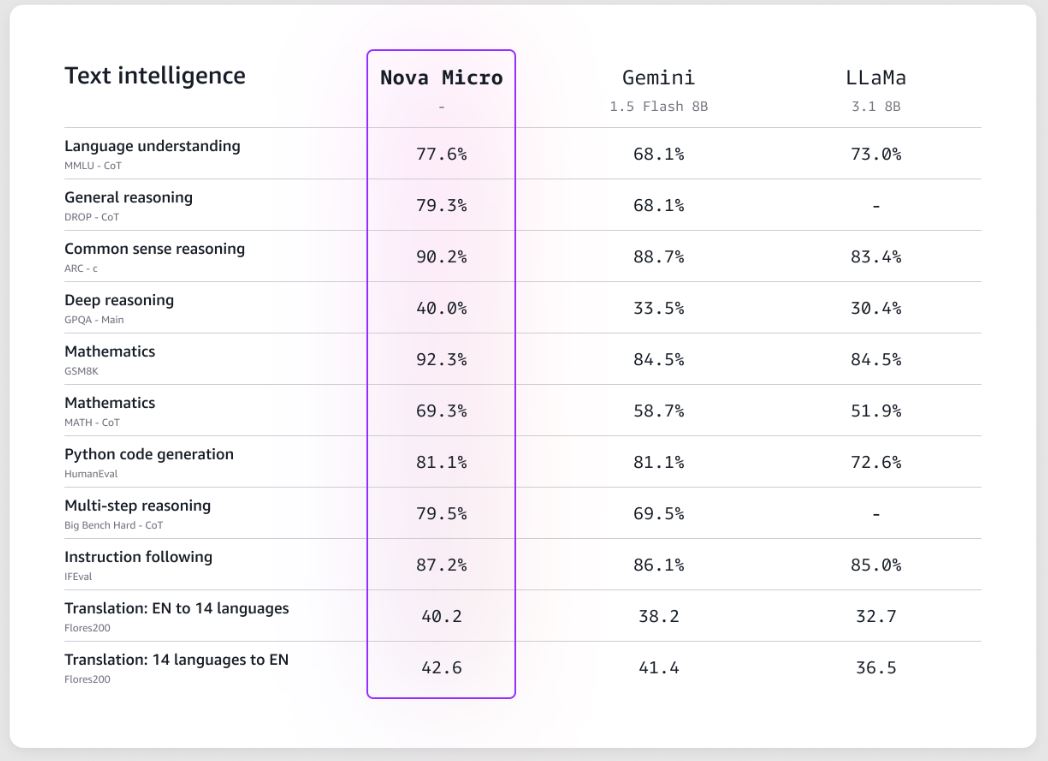

Amazon Nova

В декабре 2024 года Amazon начала презентовать новое семейство больших языковых моделей Nova. Они способны обрабатывать текст, изображения и видео в качестве подсказок, чтобы генерировать новый контент.

Компания уже показала несколько моделей:

- текстовую Nova Micro, которая обеспечивает ответы с минимальной задержкой при низкой стоимости;

- мультимодальную Nova Lite, которая быстро обрабатывает изображения, видео и текстовые входные данные;

- мультимодальную Nova Pro, более высокопроизводительную и точную модель для выполнения широкого спектра задач с высокой скоростью;

- Nova Premier, самую производительную из мультимодальных моделей для сложных задач рассуждения. Эта версия будет доступна в первом квартале 2025 года;

- Nova Canvas для генерации изображений;

- Nova Reel для генерации видео.

В 2025 году компания выпустит еще две модели Nova. Одна из них будет работать по принципу «речь-в-речь», понимать естественный язык, интерпретировать вербальные и невербальные сигналы (например, тон и интонацию), а также обеспечивать подобное человеческому взаимодействие. Вторая модель будет полностью мультимодальной, то есть будет принимать входные данные и генерировать контент в разных форматах.

➤ Подписывайтесь на телеграм-канал «РБК Трендов» — будьте в курсе последних тенденций в науке, бизнесе, обществе и технологиях.