Инженеры из стартапа в области искусственного интеллекта xAI Илона Маска, который был основан летом 2023 года, построили суперкомпьютер под названием Colossus. Он предназначен для обучения большой языковой модели компании под названием Grok, потенциального конкурента GPT-4 от OpenAI. Кластер из 100 тыс. графических процессоров Nvidia H100 построили всего за 122 дня. Разбираемся, как стартап Маска смог выполнить эту работу в рекордно короткий срок и каким образом применение мощнейших процессоров Nvidia может продвинуть xAI на первые позиции в конкурентной гонке ИИ.

Суперкомпьютер за три месяца

Расположенный в Мемфисе (штат Теннесси) новый центр обработки данных xAI вмещает 100 тыс. процессоров Nvidia Hopper H100 — больше, чем любой другой вычислительный кластер ИИ. Для сравнения: у Meta (компания признана в России экстремистской и запрещена) насчитывается 70 тыс. чипов, а у Google — 90 тыс. Маск назвал Colossus «самой мощной системой обучения ИИ в мире». Все 100 тыс. его узлов соединены единой структурой RDMA (удаленного прямого доступа к памяти), а также с единой системой охлаждения.

Графические процессоры Nvidia H100 предлагают до девяти раз большую скорость, чем предыдущие модели A100, которые в основном используют конкуренты xAI. Каждый графический процессор H100 обеспечивает до 2 тыс. терафлопс (флопс — единица, используемая для измерения производительности компьютеров). Кластер теоретически может достичь производительности около 497,9 экзафлопс (497 900 000 терафлопс), устанавливая новые стандарты в суперкомпьютерной мощности. Это значит, что кластер будет работать быстрее, чем система Aurora Министерства энергетики США, которая считается самым мощным в мире суперкомпьютером ИИ. В тесте производительности ИИ в 2024 году, который ежегодно проводит организация Top500, мощность Aurora достигла 1,012 экзафлопс.

Colossus предназначен для обучения новой языковой модели xAI Grok-3. «Мы надеемся выпустить Grok-3 к декабрю, и он должен стать самым мощным ИИ в мире на тот момент», — заявил Маск в июле.

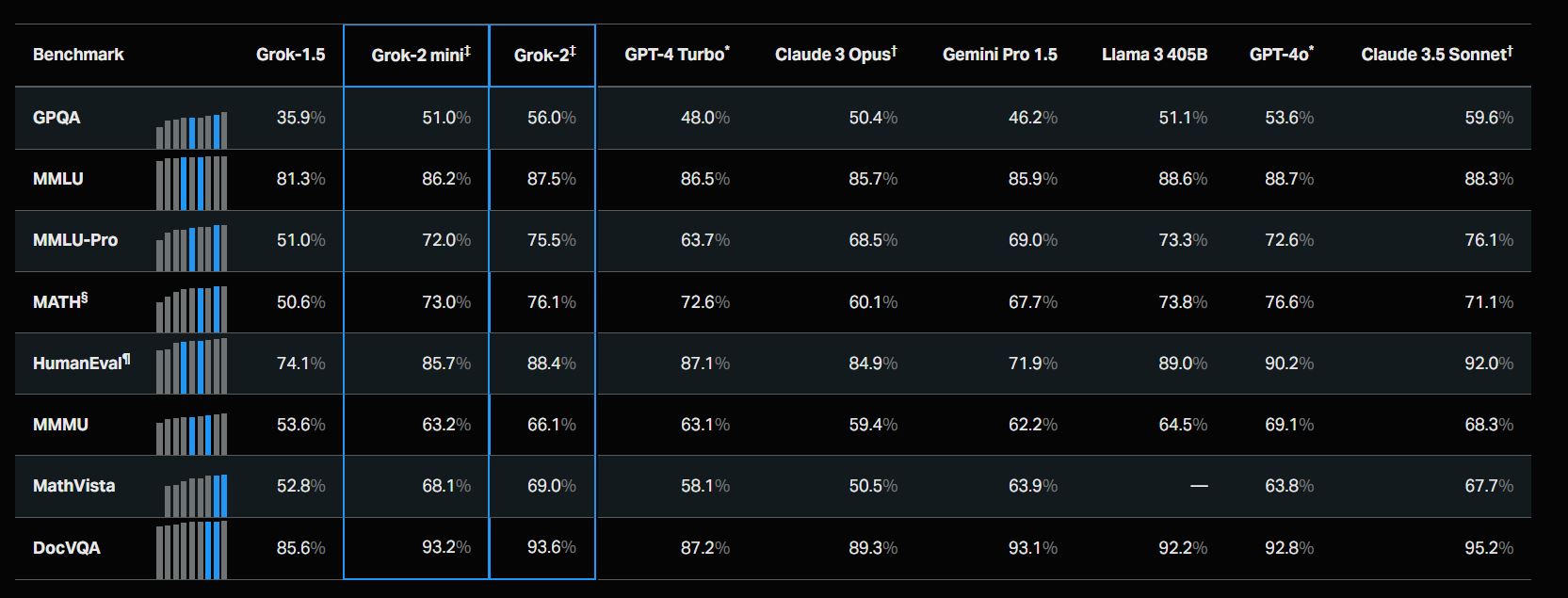

Раннюю бета-версию Grok-2 выпустили для пользователей в августе. Она была обучена всего на 20 тысячах графических процессоров Nvidia H100, но по некоторым показателям уже входит в число самых эффективных больших языковых моделей. Разработчики заявили, что Grok-2 превзошла самые мощные модели ИИ по ряду академических тестов, которые включали в себя рассуждение, понимание прочитанного, математику, естественные науки и кодирование. Так, она показала результаты выше, чем у ChatGPT-4 Turbo, Claude 3 и Gemini Pro 1.5.

Маск пообещал удвоить вычислительную мощность Colossus в течение нескольких месяцев, как только сможет закупить еще 50 тыс. более совершенных чипов серии H200 от Nvidia, которые примерно вдвое мощнее, чем H100. Всего на первом этапе кластер должен включать в себя 200 тыс. процессоров.

В перспективе xAI намерена реализовать проект по созданию «гигафабрики» для задач ИИ. Кластер в конечном итоге будет насчитывать до 300 тыс. новейших ускорителей Nvidia B200. Оборудование для платформы, в том числе серверы, поставляют также компании Dell и Supermicro.

По прогнозам Маска, его стартап сможет выпустить систему ИИ «умнее человека», вероятно, к следующему или к 2026 году.

В чем уникальность проекта

Руководитель Nvidia Дженсен Хуанг назвал задачу по созданию Colossus «сверхчеловеческой». Он отметил, что у других компаний на эту работу ушли бы годы. Хуанг сказал: «Насколько мне известно, в мире есть только один человек, который мог бы это сделать; Илон уникален в своем понимании инженерии, строительства, больших систем и распределения ресурсов; это просто невероятно».

Генеральный директор Nvidia также похвалил инженерные, программные, сетевые и инфраструктурные команды xAI и назвал их «исключительными». Он также оценил саму идею суперкластера: «Просто для сравнения, 100 тыс. графических процессоров — это, несомненно, самый быстрый суперкомпьютер на планете, который работает как один кластер».

По словам Хуанга, обычно только на планирование суперкомпьютера уходит три года, а затем начинается этап поставки оборудования, и требуется еще год, чтобы ввести его в эксплуатацию. Он отметил, что оборудование Nvidia отличается от традиционной аппаратуры в обычных центрах обработки данных, а интеграция 100 тыс. графических процессоров H200 ранее никогда не проводилась.

В целом проект требовал строительства и получения разрешений на совершенно новую «фабрику X», оснащенную передовыми системами охлаждения и энергетической инфраструктурой, а площадку в Мемфисе выбрали только в июне. После этого стартовал процесс строительства помещения и соответствующих коммуникаций, а сам монтаж суперкомпьютера, который начался в конце сентября, занял всего 19 дней. После этого на Colossus уже провели полный цикл обучения модели ИИ.

Секрет успеха xAI

xAI смог получить графические ускорители в срок, несмотря на то что несколько крупных технологических компаний, включая Microsoft, Google и Amazon, конкурируют за чипы Nvidia. Однако Маск считается приоритетным клиентом, поскольку он пообещал потратить от $3 млрд до $4 млрд только в этом году на оборудование для нужд ИИ. Кроме того, xAI получила преимущество за счет использования чипов ИИ, уже поставленных Tesla для создания автопилота. В августе Tesla анонсировала создание собственного кластера Cortex AI с 50 тыс. графических процессоров Nvidia H100.

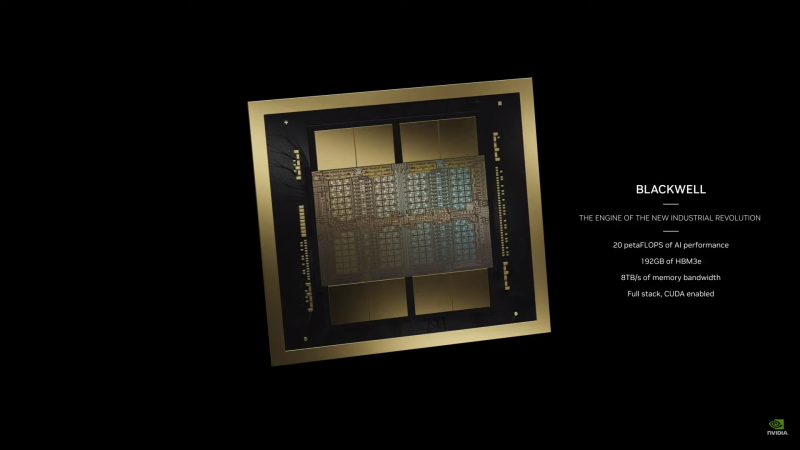

Таким образом, стартап сможет претендовать на закупку новейших графических процессоров Nvidia, которые компания представила в марте 2024 года. Они называются Blackwell B200 AI, а производительность пары таких чипов оценивается в 20 петафлопс. Новый графический процессор будет стоить $30–40 тыс., в 25 раз дешевле, чем H100.

Деньги на закупку оборудования у стартапа есть — ранее в этом году xAI объявила, что привлекла $6 млрд в новом раунде финансирования с помощью венчурных капиталистов, таких как Andreessen Horowitz и Sequoia Capital, а также инвесторов Fidelity и Kingdom Holding саудовского принца Альвалида бин Талала. Сейчас стартап оценивается в $24 млрд.

Маск также дал понять, что предложит совету директоров Tesla проголосовать за инвестирование $5 млрд в xAI.

Возможные проблемы

Строительство суперкомпьютера вызвало обеспокоенность жителей Мемфиса. Одной из главных проблем работы кластера станет нагрузка, которую он создаст на городские коммунальные системы. Чиновники муниципальной коммунальной службы MLGW подсчитали, что Colossus требует до 3,7 млн л воды в день для охлаждения серверов и будет потреблять до 150 МВт электроэнергии. Такой объем электроэнергии ежедневно потребляет 120 тыс. среднестатистических американских домохозяйств. Энергетическая корпорация Tennessee Valley Authority может предоставить только 50 МВт электроэнергии. В связи с этим возникли опасения, что большинство систем будут простаивать в ожидании ресурсов.

Однако журналисты проанализировали спутниковые снимки и выяснили, что стартап Маска привез на будущую гигафабрику ИИ 14 мобильных генераторов природного газа VoltaGrid, подключенных к четырем мобильным подстанциям. Каждый из этих генераторов размером с полуприцеп может обеспечить дополнительные 2,5 МВт мощности, а всего они дают 35 МВт, что позволяет увеличить совокупную мощность до 93 МВт.

xAI также взяла на себя обязательство построить новую электроподстанцию и установку по переработке использованной воды. Судя по тому, как движется разработка кластера Tesla Cortex AI, проблему с охлаждением также удастся решить. Ранее Маск опубликовал снимок огромных вентиляторов, которые строятся для охлаждения суперкластера.

Вентиляторный блок охлаждает жидкостную систему от Supermicro, рассчитанную на нагрузку в 500 МВт. Для сравнения: средняя угольная электростанция может вырабатывать около 600 МВт электроэнергии.

👀 Следите за телеграм-каналом «РБК Трендов» — будьте в курсе последних тенденций в науке, бизнесе, обществе и технологиях.