О дипфейках активно заговорили в конце 2017 года, когда в интернете стали появляться поддельные видео с мировыми знаменитостями — в оригиналах видеозаписей звезды не снимались, их лица были добавлены в ролики с помощью искусственного интеллекта. Однако со временем дипфейки вышли за рамки индустрии развлечений — поддельные изображения, видео, аудио стали делать с самыми разными людьми и объектами.

Развлечение или угроза

Дипфейки начали использоваться не только для развлечения, но и для мошенничества, дезинформации, политических манипуляций и кибербуллинга. Технология создания дипфейков, основанная на нейросетях и алгоритмах машинного обучения, позволяет имитировать действия и речь людей с высокой степенью реалистичности.

Постепенно дипфейки стали угрозой даже для судов, страховых компаний, исследовательских институтов, в которых подлинность доказательств и источников особенно важна. Так что же мешает дипфейкам проникнуть в другие сферы, включая медицину? Ничего. С помощью искусственного интеллекта можно создавать дипфейки на медицинскую тематику, например, статистические данные пациентов, медицинские снимки (КТ, МРТ, рентгеновские изображения), видео с врачами, научные публикации и исследования. Это может быть полезно для развития медицины и науки, но несет серьезные риски, если использовать дипфейки со злым умыслом.

ИИ и его возможности в создании дипфейков произвели революцию в различных областях, включая медицину. Дипфейки, основанные на ИИ, позволяют создавать поддельные, но реалистичные изображения, видео и аудиозаписи, которые могут включать медицинские данные пациентов, такие как статистические отчеты, результаты компьютерной томографии (КТ), магнитно-резонансной томографии (МРТ) и рентгеновские снимки. Эти технологии также позволяют моделировать видео с участием врачей, а также подделывать научные публикации и исследования.

Что если злоумышленники начнут создавать дипфейковые снимки с травмами, чтобы получать больничные или страховые выплаты? Или биотехнологические компании с амбициями Theranos (американский стартап, продвигавший поддельную технологию анализа крови) смогут использовать дипфейковые изображения для фальсификации данных с целью привлечения венчурного финансирования? Или фальшивки будут использовать для популяризации непроверенной медицинской информации или продажи нелицензированных лекарств? Это становится реальностью прямо сейчас.

(Дип) фейковые врачи

Хилари Джонс, британский врач и популярный медицинский эксперт, стал жертвой дипфейка. Джонс стал известен благодаря своему многолетнему опыту работы на телевидении, где он давал советы насчет здоровья, разъяснял медицинские термины и развеивал страхи по поводу различных заболеваний. Он приобрел большую репутацию и доверие публики.

В одной из социальных сетей появился рекламный ролик, в котором якобы Джонс рекламировал новый чудо-препарат, утверждая, что он способен эффективно бороться с несколькими серьезными заболеваниями одновременно. Этот ролик выглядел настолько убедительно, что многие поверили в подлинность информации и стали интересоваться препаратом, а также делиться этим видео с другими.

Однако, как выяснилось позже, видео было создано с помощью технологии дипфейк. Это значит, что Джонс не только не снимал этот ролик, но и не имел никакого отношения к рекламируемому препарату. Технология использует алгоритмы ИИ для синтеза реальных человеческих лиц и голосов, создавая очень правдоподобные фальшивые видеоматериалы. Создатели такого контента могут манипулировать изображением и звуком, чтобы создать иллюзию, что человек говорит или делает что-то, чего на самом деле он не делал.

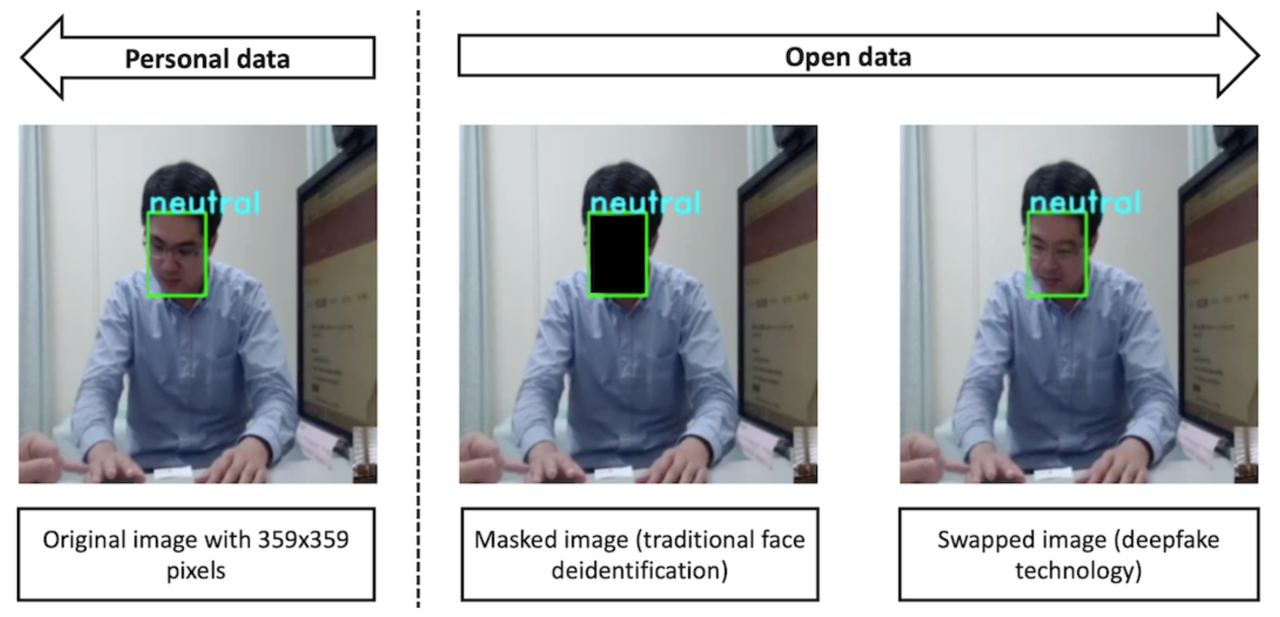

Это происшествие привлекло внимание общественности и вызвало обеспокоенность по поводу возможного вреда от дезинформации в медицинской области. Но использование дипфейков в медицине не ограничивается созданием видео с докторами — использование GAN (генеративных нейросетей наподобие Midjourney, Dall-E и пр.) позволяет создавать даже медицинские снимки.

Поддельные медицинские изображения и данные

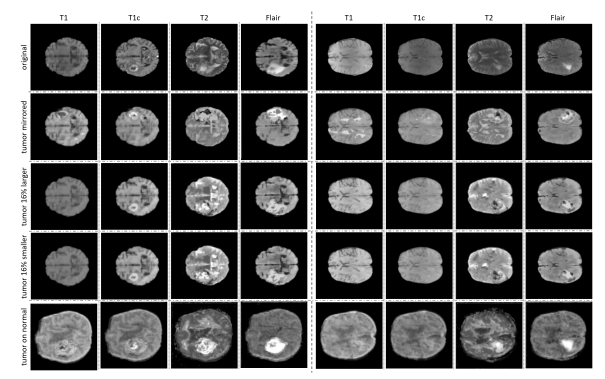

В исследовании 2019 года, проведенном в Израиле, эксперты в области кибербезопасности и медицинских наук создали несколько дипфейк КТ-сканов, чтобы продемонстрировать возможность добавления или удаления опухолей из изображений. Эти подделки вводили в заблуждение рентгенологов, заставляя их поверить в подлинность снимков. В ходе исследования рентгенологи, не зная об изменениях, диагностировали 99% КТ-сканов с добавленными опухолями как злокачественные, а 94% КТ-сканов с удаленными опухолями — как снимки здоровых пациентов. Даже после того, как им сообщили о возможности редактирования изображений, они неправильно диагностировали 60% добавленных опухолей и 87% удаленных.

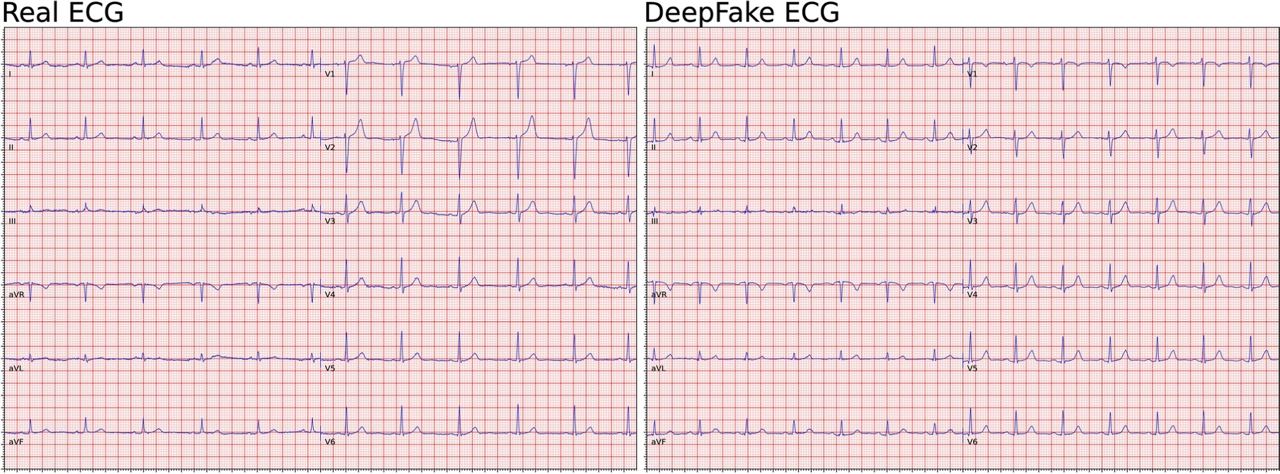

В аналогичном исследовании 2021 года ученые смогли создать реалистичные и убедительные подделки электрокардиограмм. Даже наш самый распространенный инструмент для записи сердцебиения может быть легко фальсифицирован.

Согласно данным American Journal of Managed Care, на больницы приходится треть всех крупных утечек данных у поставщиков медицинских услуг в США. Хотя многие из этих атак все еще используют фишинг или другие виды мошенничества с электронными письмами для проникновения в систему, все чаще применяются более сложные схемы. Наивно полагать, что дипфейки не станут частью следующего поколения кибератак в медицине, будь то больницы, компании медицинских технологий или государственные департаменты здравоохранения.

Однако, несмотря на все потенциальные угрозы, использование дипфейков в медицине и науке открывает перед исследователями и медицинскими работниками новые горизонты.

Например, поддельные данные могут использоваться для обучения и тренировки медицинского персонала без риска для реальных пациентов, что способствует повышению уровня профессиональной подготовки. Технология Deepfake может использоваться не только для клинических изображений.

В исследовании, опубликованном в Journal of Internet Medical Research учеными из Тайбэйского медицинского университета, система распознавания эмоций, обученная на более чем 28 тыс. азиатских лицах, была использована для создания видеороликов с трансформацией черт лица 327 реальных пациентов. Эти видеоролики предназначены для повышения эмпатии врачей и защиты конфиденциальности пациентов. Система напоминала медикам о необходимости изменить свое поведение в соответствии с эмоциями пациентов. В целом, система достигла уровня обнаружения эмоций более 80% на реальных данных.

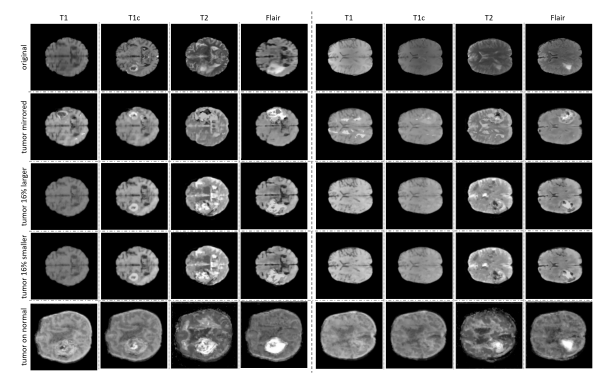

Также возможно создание симуляций редких или сложных клинических случаев, что помогает медикам лучше подготовиться к реальной практике. Например, обучение цифровой системы распознавать опухоли на изображениях может быть затруднено из-за того, что такие аномалии встречаются редко по сравнению с нормальными образцами. Небольшое количество примеров с опухолями может привести к низкой точности алгоритма ИИ.

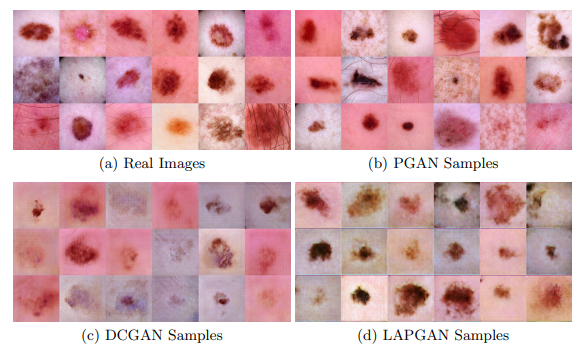

Используя синтетические изображения вместе с настоящими в генеративно-состязательных сетях (GAN), можно значительно улучшить точность системы, как показали исследователи из клиники Майо и Центра клинических данных MGH & BWH. В статье авторы рассказали, как использовали нейросети для создания синтетических изображений МРТ мозга с опухолями.

Другая статья показывает, как нейросети могут создавать реалистичные изображения поражений кожи, которые дерматологам трудно отличить от настоящих фотографий.

Еще одно недавнее исследование рассматривает искусственный интеллект как инструмент для создания примеров поражений печени.

Дипфейки представляют собой технологию с огромным потенциалом, которая может как улучшить различные аспекты нашей жизни, так и создать серьезные угрозы. В медицине использование дипфейков открывает новые возможности для обучения, исследований и повышения точности диагностических алгоритмов. Однако риски, связанные с фальсификацией медицинских данных, страховыми мошенничествами и кибератаками, требуют пристального внимания и разработки эффективных мер защиты. Например, цифровых водяных знаков, которые позволят однозначно идентифицировать дипфейковый контент.