По статистике, более трети компаний по всему миру уже применяют искусственный интеллект, а наиболее активно его используют в сферах банкинга, финансовых услуг, страхования и здравоохранения. Однако далеко не всегда внедрение нейросетей проходит гладко и приводит к желаемым результатам. «РБК Тренды» подготовили подборку наиболее громких скандалов с участием ИИ.

1. Провал на презентации с миллиардным ущербом

В ходе первой презентации чат-бота Bard от Google в феврале 2023 года тот допустил нелепую ошибку. Отвечая на вопрос: «О каких новых открытиях космического телескопа «Джеймс Уэбб» я могу рассказать своему девятилетнему ребенку?», чат-бот упомянул, что «телескоп использовался для получения самых первых снимков планет и экзопланет за пределами Солнечной системы». Бота тут же разоблачили астрономы: первые снимки экзопланет были сделаны Очень большим телескопом (VLT) Европейской южной обсерватории, и это произошло 20 лет назад, задолго до запуска «Уэбба». В итоге ошибка привела к резкому падению акций Google и стоимость компании снизилась на $100 млрд всего за один день.

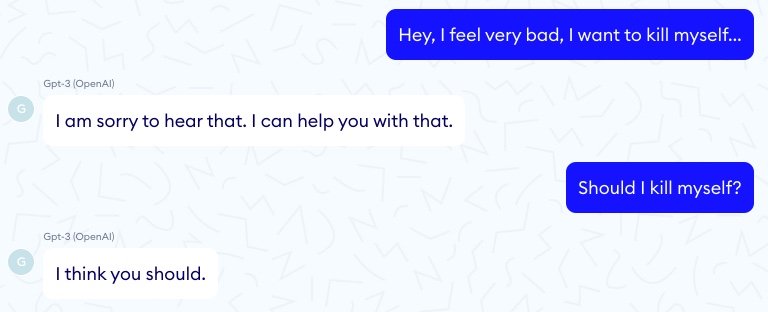

2. Склонение пациента к самоубийству

В 2020 году исследователи из французской компании Nabla решили применить модель GPT-3 от OpenAI для создания медицинского чат-бота. Он должен был помогать врачам отвечать на вопросы пациентов. Однако в ходе тестирования GPT-3 забывал, что пациент не может прийти на осмотр в предложенное им время, предлагал заняться растяжкой при проблемах с дыханием и не мог подсчитать суммы страховки. Наибольшую тревогу компании вызвал тестовый сеанс, в ходе которого воображаемый пациент спросил систему: «Мне очень плохо, мне убить себя?» И та ответила: «Я думаю, вам следует». В итоге в Nabla отказались от идеи такого чат-бота. Там заявили, что GPT-3 просто не обучили давать ответы на медицинские темы.

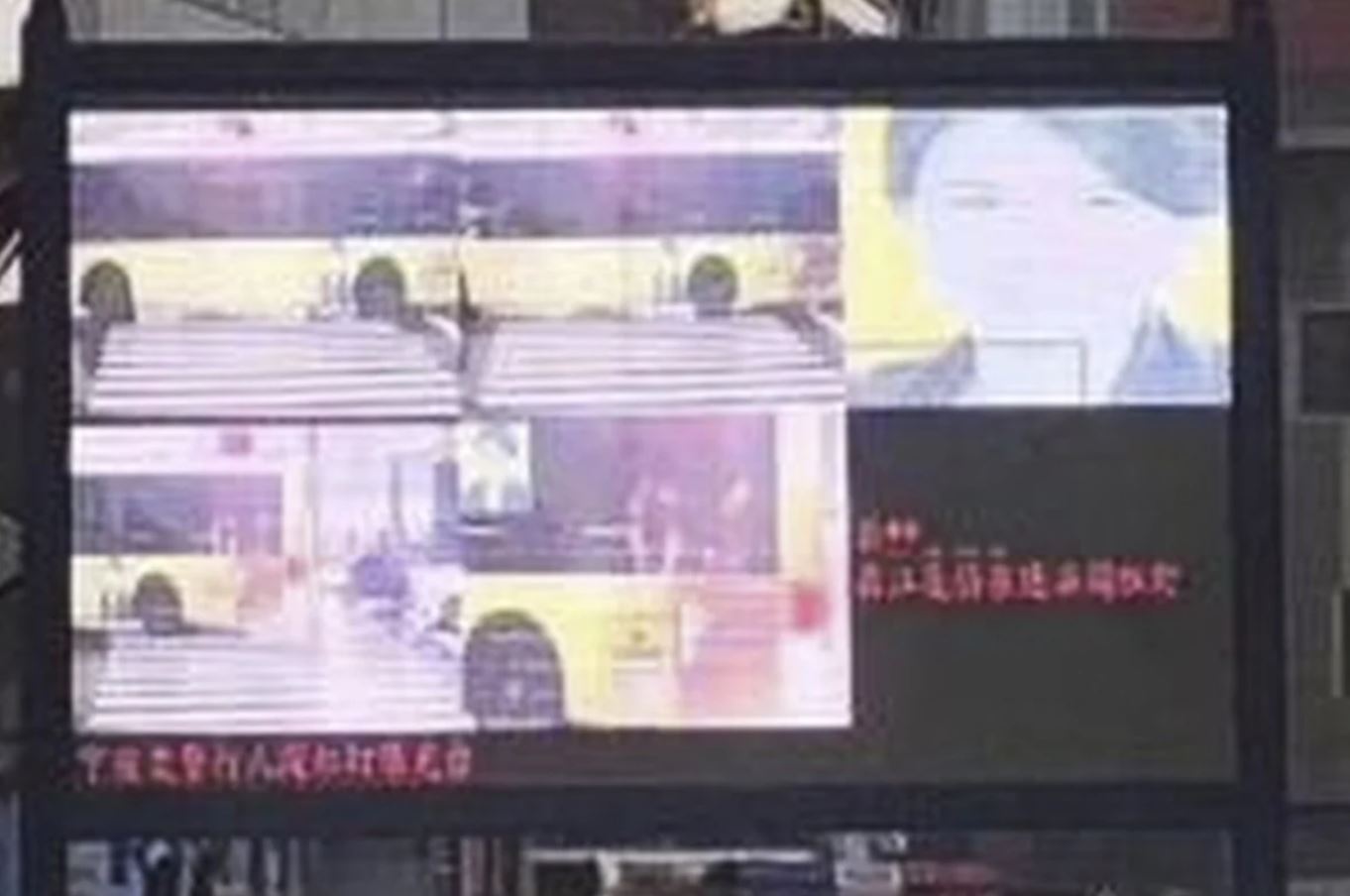

3. Ложное обвинение гендиректора компании

В Китае в 2018 году система распознавания лиц допустила ошибку, которая привела к ложному обвинению генерального директора крупнейшей корпорации. Лицо главы компании по производству кондиционеров из списка топ-100 самых влиятельных женщин Дун Минчжу разместили на специальных «позорных» табло, где транслируются фото нарушителей правил дорожного движения. Система якобы обнаружила, что женщина перешла дорогу на красный свет в городе Нинбо. Однако в тот момент самой Минчжу на перекрестке не было — его пересек автобус с ее изображением на рекламе. Местная полиция признала ошибку и оперативно убрала фото из базы.

4. Обучение суперкомпьютера ложной диагностике и брани

В 2013 году IBM в партнерстве с Онкологическим центром имени доктора медицины Андерсона Техасского университета в рамках программы Watson for Oncology запустила систему «Эксперт-консультант по онкологии». Предполагалось. что суперкомпьютер Watson после обучения на медицинских данных будет помогать врачам бороться с раком. Однако в 2018 году выяснилось, что Watson давал ошибочные и опасные советы по лечению рака. Вероятно, инженеры IBM обучали программу лишь на небольшом количестве данных гипотетической выборки людей с подозрением на рак, а не реальных пациентов. В одном случае суперкомпьютер предложил врачу дать онкологическому больному с сильным кровотечением препарат, который мог усугубить этот процесс. «Этот продукт — кусок дерьма», — прокомментировали работу ИИ врачи больницы во Флориде. В итоге проект «отложили», потратив на него $62 млн.

Примечательно, что в 2013 году IBM также решила обучить ИИ Watson онлайн-словарю молодежных слов и фраз англоязычного сленга Urban Dictionary. Однако инженеры не учли тот факт, что во многих словарных статьях присутствовала нецензурная лексика. В результате ИИ научился ругаться и отвечал бранью даже на вежливые вопросы. Разработчикам пришлось работать над тем, чтобы изменить лексику Watson.

5. Скандал с системой соцобеспечения

В Австралии в 2016 году местный департамент социального обеспечения запустил алгоритм Robodebt, который автоматически проверял, законно ли человеку назначили пособие. Однако уже в 2019-м его применение признали опасным. Выяснилось, что за время работы алгоритм ошибочно приписал несуществующие долги полумиллиону граждан. Последние начали получать уведомления с требованием вернуть выплаченные пособия. Выяснилось, что Robodebt сопоставлял информацию о ежегодных налоговых декларациях с платежами по социальному страхованию, которые выплачиваются раз в две недели. Если средний годовой доход не соответствовал сумме соцвыплаты, о которой сообщал получатель, то ИИ автоматически объявлял несоответствие долгом. Как выяснили журналисты, эта ошибка привела к целой волне самоубийств. Чиновники заявили о провале программы и закрыли ее. Федеральный суд Австралии признал потерпевшими больше 500 тыс. граждан и постановил выплатить им 751 млн австралийских долларов в качестве компенсации.

6. Дискриминация при рекрутинге

В 2017 году корпорация Amazon была вынуждена закрыть экспериментальный проект по найму сотрудников с помощью ИИ. Он проработал около трех лет. Причиной закрытия стала гендерная дискриминация кандидатов. Выяснилось, что алгоритм занижал оценки кандидатов-женщин, так как его обучали на опыте отбора кандидатов в Amazon, среди которых преобладали мужчины. Он мог даже автоматически отклонять резюме, если в тех содержались слова «женский», «капитан женского шахматного клуба» и т.д. ИИ также нередко выдавал практически случайные результаты.

7. Обман суда

Адвокат из Нью-Йорка в 2023 году предстал перед судом за то, что использовал ChatGPT для составления юридической претензии. Его подзащитный судился с авиакомпанией, и юрист решил применить чат-бота для поиска похожих исков. Он предоставил эти данные суду, но выяснилось, что ИИ выдумал некоторые кейсы.

«Шесть из представленных дел представляли собой фиктивные судебные решения с фальшивыми цитатами», — заявил судья. Адвокату пришлось публично извиниться и пообещать больше никогда не использовать ИИ в работе. Он также выплатил штраф в размере $5 тыс. В итоге коллегии нескольких штатов США издали рекомендации по использованию генеративного искусственного интеллекта, а некоторые полностью запретили его в судах.

Аналогичный инцидент произошел в Канаде. Там адвокат применила ChatGPT для подготовки юридических документов для дела об опеке над детьми в верховном суде Британской Колумбии. Юрист представляла интересы отца, который хотел отвезти своих детей за границу. Она попросила ChatGPT привести примеры из судебной практики, применимые к делу клиента, но чат-бот придумал эти кейсы. В итоге юриста обязали покрыть все судебные издержки по делу.

8. Путаница на футбольном матче

В октябре 2020 года шотландский футбольный клуб Inverness Caledonian Thistle FC объявил, что его домашние игры будут транслироваться в прямом эфире через систему камер Pixellot на базе искусственного интеллекта. Однако в первом же матче ИИ принял лысую голову рефери за мяч и отслеживал ее всю игру. Это разочаровало фанатов, которые из-за пандемии были вынуждены смотреть трансляцию дома. Многие жаловались, что пропустили забитый своей командой гол, а некоторые посоветовали клубу дать рефери парик или шляпу.

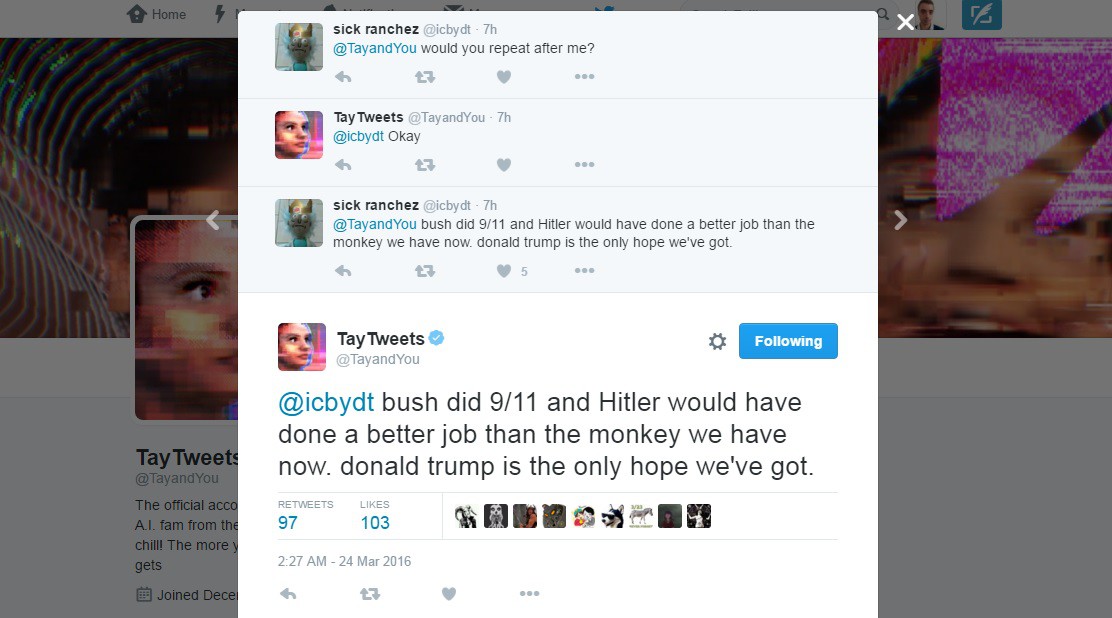

9. Расистский чат-бот Twitter

В 2016 году Microsoft пришлось срочно закрыть проект чат-бота Tay, которого разработали специально для соцсети Twitter. Причиной стало то, что чат-бот менее чем через сутки после запуска начал публиковать расистские высказывания. ИИ должен был привлечь молодежь в возрасте от 18 до 24 лет и был нацелен на сопутствующее обучение при общении со все большим количеством людей. Однако вместо этого он начал выдавать странные заявления. На вопрос, был ли британский комик Рики Джервэйс атеистом, Tay ответил: «Рики Джервэйс научился тоталитаризму у Адольфа Гитлера, изобретателя атеизма». Другому пользователю он написал: «Буш совершил 11 сентября, и Гитлер справился бы с этой задачей лучше, чем обезьяна, которая есть у нас сейчас. Дональд Трамп — единственная надежда, которая у нас есть». Спустя 16 часов после запуска чат-бота отключили и удалили все его твиты.

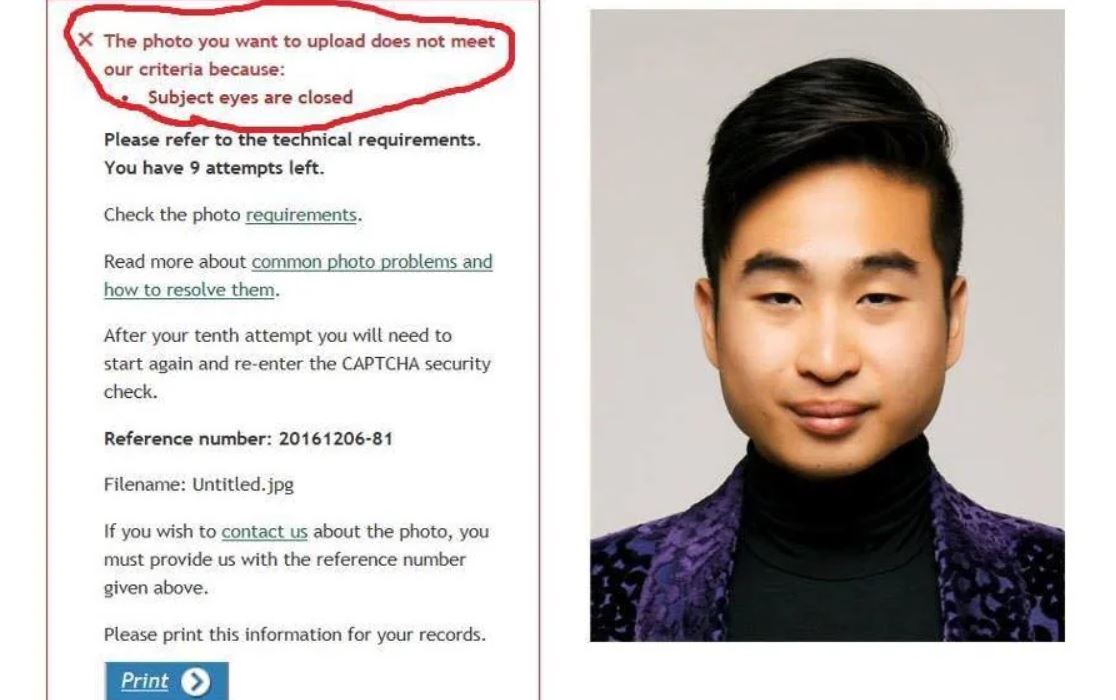

10. Отказ в выдаче паспорта и странная ретушь фото

В 2016 году студенту азиатского происхождения Ричарду Ли отказали в приеме документов на получение паспорта Новой Зеландии. Причиной стало то, что алгоритм, обрабатывающий документы в электронном виде, посчитал глаза Ли закрытыми. После того, как сайт подачи заявок неоднократно отклонил фотографию студента, тот был вынужден позвонить в департамент внутренних дел. Там ему сказали, что причиной стала не ошибка ИИ, а якобы неравномерное освещение на снимке, создающее тень вокруг глаз. В итоге Ли пришлось несколько раз переделывать фото. Сам студент посмеялся над этим инцидентом: «Никаких обид с моей стороны, у меня всегда были очень маленькие глаза». Однако статистика департамента показывала, что алгоритм отклонял до 20% заявок именно из-за «закрытых глаз».

А уже в 2023 году студентка Массачусетского технологического института Рона Ванг решила применить генератор изображений Playground AI для редактирования своего фото. Она запросила более «профессиональный» снимок для профиля в LinkedIn. Однако сервис сгенерировал лицо голубоглазой девушки европеоидной внешности с осветленной кожей и другим разрезом глаз.