Об авторе: София Труцуненко, методический лид направления Data Science школы IT-профессий Skillfactory.

Любой, кто работал с большими моделями ИИ (ChatGPT, Midjourney), знает, что сгенерированные тексты и изображения часто требуют коррекции или дополнительных уточнений. Нейросеть может придумывать цифры, создавать фальшивые объекты или признаки, которых на самом деле не было в исходных данных. Это довольно частое явление для больших генеративных моделей, которое еще называют галлюцинациями. Но за неправильными результатами могут скрываться не только ошибки модели, но и злонамеренные действия — отравление данных.

Что такое отравление данных

Отравление данных (data poisoning) — это атака на машинное обучение, во время которой злоумышленник вводит вредоносные данные в обучающий набор для нарушения работы алгоритма обучения и снижения его эффективности.

Чтобы понять, как работает отравление данных, нужно разобраться, как в общем работают алгоритмы машинного обучения. Изначально собирается большой набор данных, и от того, какие именно данные взяли, зависит результат. Следующий шаг — привести данные к одному формату, а для некоторых задач — дополнительно снабдить их подсказками для алгоритма (разметкой). Далее алгоритм находит в них признаки и закономерности.

И когда обученный алгоритм сталкивается с данными, которые он еще не видел, он может решить эту задачу, опираясь на те правила, которые он для себя создал ранее. Отравление данных нарушает этот процесс, подмешивая в обучающий набор вредоносные сведения, которые искажают или запутывают обученный алгоритм.

Рассмотрим некоторые примеры таких атак:

- Внесение шума (Noise Injection): добавление случайных или искаженных данных в обучающий набор.

- Удаление данных (Data Removal): исключение части данных из обучающего набора.

- Вставка ложных объектов (Object Insertion): добавление несуществующих или ложных объектов в обучающий набор. Сюда же входят скрытые надписи, вотермарки, изображения.

- Изменение меток классов (Label Flipping): изменение или искажение разметки классов в обучающем наборе. То есть данные не добавляются, но происходит подмена: например, картинки с кошками подписываются как картинки с собаками и наоборот.

Но гораздо интереснее те методы, которые нельзя заметить, ведь современные отравленные данные могут выглядеть нормально для человеческого глаза, но при этом они тоже будут ломать алгоритм. Одним из самых громких примеров отравления данных является программа Nightshade, созданная исследователями Чикагского университета. Это ответ на достаточно больную этическую тему для больших генеративных ИИ-моделей — проблему авторского права.

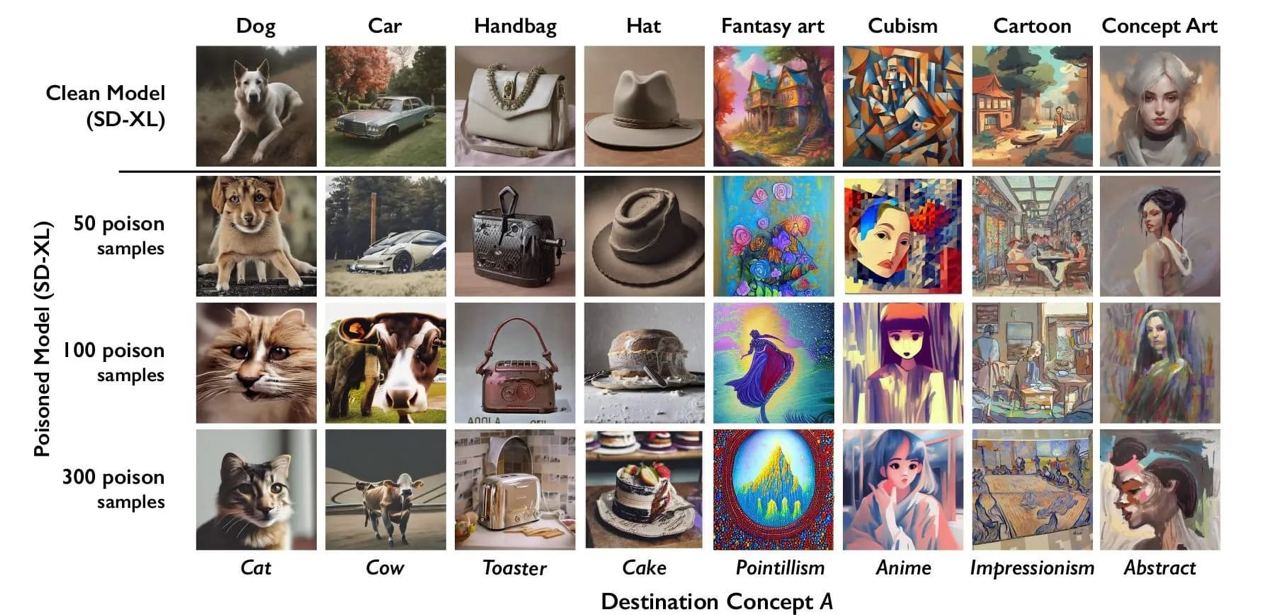

Чтобы обучить качественную модель на уровне DALL–E и Midjourney, нужно не просто много данных — нужно очень много данных. И многие большие модели не обладают правами на работы, которые использовались в обучении. А результат работы — сгенерированная картинка, которая не имеет признаков интеллектуальной собственности. Nightshade незаметно вставляет признаки одного объекта на картинки с другим. Там, где человеческий глаз увидит собаку, нейронная сеть может воспринимать признаки и контуры другого объекта, например кота. Это позволяет создавать искажения в изображениях, которые остаются незамеченными человеком, но влияют на работу модели искусственного интеллекта, обученной на этих данных. Изображения меняются таким образом, что видимая разница минимальна.

Зоны риска

Отравление данных — это очень серьезный метод воздействия на системы искусственного интеллекта, он может привести к различным по степени негативным последствиям в зависимости от контекста и особенностей атаки. На эффективность отравления данных влияют степень его скрытности и сложность обнаружения изменений.

Цели атаки и контекст также влияют на последствия — от обмана локальных систем безопасности до воздействия на масштабные финансовые или медицинские системы.

Сейчас отравление данных существует и на уровне прикладных инструментов для незащищенных некрупных систем, и как глобальная угроза безопасности, которая изучается ведущими учеными и отраслевыми специалистами.

Искусственный интеллект внедряется во все чувствительные сферы нашей жизни: финансы, медицину, пропускные системы и даже поиск преступников. Последствия отравления данных могут быть катастрофическими. Вот несколько примеров.

- Распознавание лиц: злоумышленник может добавить в обучающий набор чужие изображения лиц, взятые из открытых источников. Это может привести к тому, что невиновного человека задержат правоохранительные органы.

- Медицинские данные: подмена истории болезни пациента или результатов анализов в медицинских приложениях. Такая атака может привести к ложному диагнозу.

- Финансовые данные: из-за добавления фальшивых транзакций или ухищрений в финансовые данные человеку могут предъявить необоснованные обвинения в финансовых махинациях. А атака большего масштаба может спровоцировать дестабилизацию рынка.

- Дорожная ситуация (беспилотные автомобили): злоумышленник может добавить деформированные дорожные знаки или маркировку на дорогах в систему распознавания. Это может привести к авариям и несчастным случаям.

Способы защиты

Чтобы минимизировать риски отравления данных, необходим системный подход к кибербезопасности. С одной стороны, он должен включать традиционные методы: мониторинг сетей, использование брандмауэров, антивирусов и обновление программного обеспечения. Кроме того, для обнаружения вредоносных воздействий алгоритмами машинного обучения могут решаться такие задачи, как мониторинг аномалий, фильтрация и валидация данных после обучения.

Специалисту, работающему с большими моделями и сложными признаками, важно регулярно мониторить и изучать данные, которые он использовал для обучения моделей искусственного интеллекта. Это позволит своевременно выявлять подозрительные или аномальные паттерны, которые могут свидетельствовать о внедрении отравленных данных.