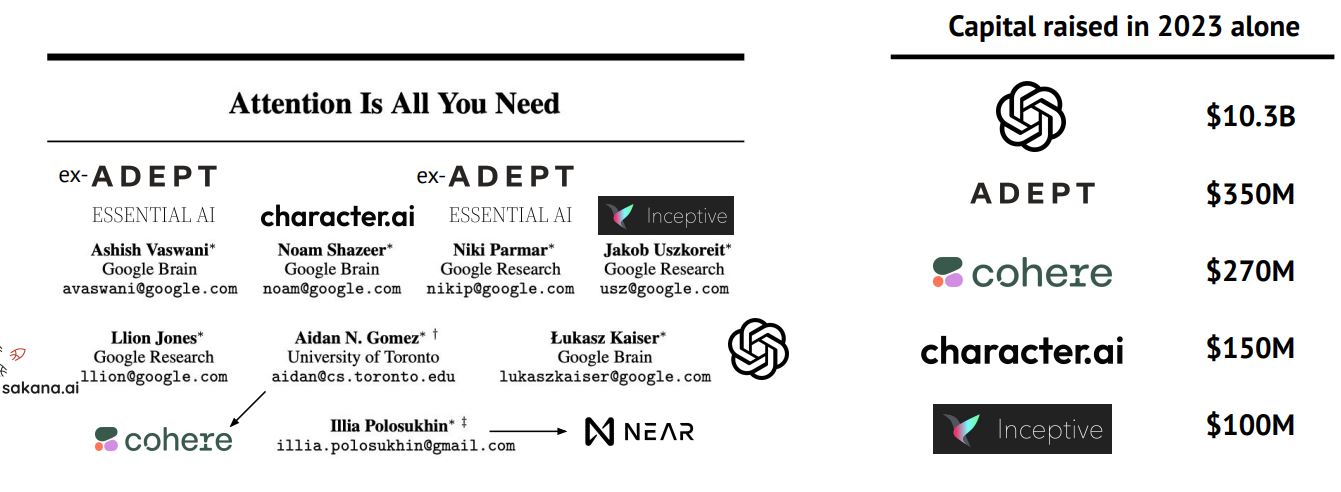

Генеративный ИИ лидирует на рынке венчура

По мнению экспертов, именно стартапы, занимающиеся разработкой генеративных нейросетей, не позволили упасть рынку венчурного капитала. На фоне падения оценочной стоимости IT-компаний стартапы сосредоточились на ИИ-приложениях и привлекли более $18 млрд. В 2023 году корпорации также переориентировали свои инвестиции на генеративный ИИ. Одновременно они сократили вложения в компании, не связанные с искусственным интеллектом, на 50% в годовом выражении. Инвестиции в ИИ же сохраняют стабильность — $29 млрд в 2022 году против $22 млрд в 2023-м.

Одновременно растет интерес обычных людей к взаимодействию с чат-ботами. Так, стартап Character.AI, который привлек $150 млн в первом раунде финансирования, сообщил о 200 млн ежемесячных пользователей своего приложения. Платформа Discord, которая интегрировала нейросеть Midjourney для генерации изображений, заявляла, что каждый месяц приложением пользуются около 30 млн человек, которые создают более 1 млрд уникальных изображений.

Методы обучения ИИ исчерпали себя

Как отмечают эксперты, модель GPT-4 от OpenAI смогла превзойти другие нейросети — как по классическим тестам для ИИ, так и по итогам экзаменов для оценки способностей человека. Кроме того, модель подтвердила эффективность метода обучения с подкреплением на основе отзывов людей (reinforcement learning from human feedback, RLHF). Однако этот метод требует найма персонала для оценки и ранжирования результатов модели, а также моделирования предпочтений, что делает эту технику сложной, дорогой и предвзятой. Это побудило исследователей искать альтернативы. Так, команда из Университета Беркли уже продемонстрировала, как точная настройка небольших языковых моделей (small language models, SLM) на основе результатов более крупных языковых моделей (large language models, LLM) позволяет создавать более стилистически богатые тексты, но и с более низкой точностью ответов. В связи с этим исследователи предлагают метод обучения, основанный на предварительной оценке входных данных.

Однако в ближайшее время метод обучения с подкреплением продолжит лидировать в сфере ИИ, уверены эксперты. Вероятно, компании будут улучшать его путем выпуска моделей меньшего размера и лучших наборов заранее отсортированных и проверенных людьми данных.

Еще одна проблема в обучении ИИ связана с тем, что уже к 2025 году запас открытых данных может закончиться. Как уточняют исследователи из Epoch AI, запас языковых данных высокого качества будет исчерпан к 2026 году, а низкого — к 2030–2050 годам. По мнению авторов отчета, после этого разработчики ИИ начнут использовать датасеты компаний для обучения моделей, а также будут активнее применять в этих целях сгенерированный контент.

Движение за открытость данных ИИ растет

В связи с экономическими и иными рисками такие компании, как OpenAI, не раскрывают данные, которые они используют для обучения моделей. Однако, как отмечают авторы отчета, движение за открытость датасетов ИИ растет. Первой его поддержала Meta (признана экстремистской, ее деятельность в России запрещена). В феврале 2023 года компания выпустила серию моделей под названием LLaMa, обученных исключительно на общедоступных наборах датасетов. После этого к движению за публикацию данных присоединились и другие организации, в том числе MosaicML с моделью MPT-30B, TII UAE с Falcon-40B, Together с RedPajama и Eleuther с Pythia. Уже в июле 2023 года Meta выпустила серию моделей LLaMa-2, которые любой желающий может использовать в коммерческих целях.

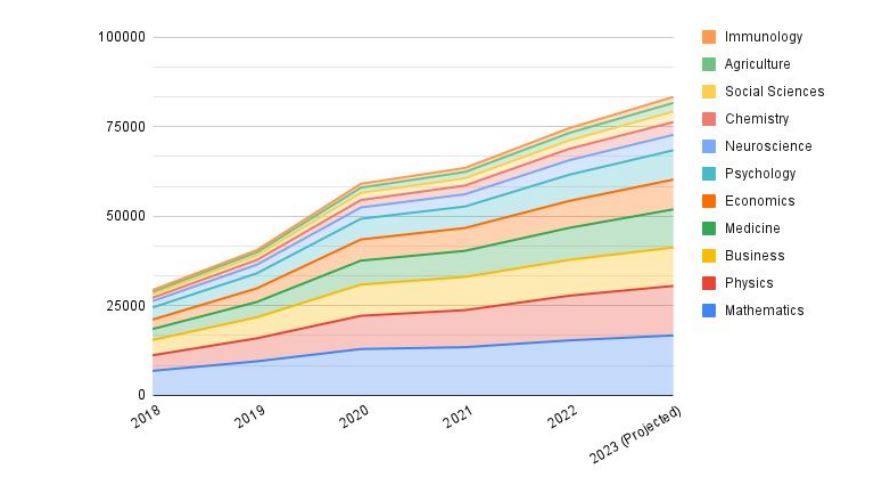

ИИ помогает совершать прорывы в науке

Современные языковые и диффузионные модели нейросетей, которые извлекают данные из «зашумленных» изображений, активно используются для прорывных открытий в медицине, биологии и фармацевтике. Так, они уже решили проблему спонтанного сворачивания белков и научились предсказывать последовательность аминокислот в них в результате этого процесса. Теперь нейросети генерируют новые структуры белков. Одна из последних моделей, Evolutionary Scale Modeling-2 (ESM-2), используется для характеристики структуры белков, обнаруженных в почве, бактериях, воде и т.д., и работает значительно быстрее предшественника AlphaFold-2. Результаты по миллионам белков удалось получить всего за две недели с использованием кластера из 2 тыс. графических процессоров. Другие модели имеют более узкую направленность — например, Mind’s Eye от Google, которая запускает симуляцию, чтобы ответить на логические вопросы по физике.

Как предсказывают эксперты, следующим рубежом развития ИИ в науке станет его мультимодальность. Так, Google создала MultiMedBench — набор данных для 14 разных задач, включая медицинские вопросы и ответы, интерпретацию изображений маммографии и дерматологии, создание радиологических отчетов и обобщение геномных данных для выявления отклонений, которые могут вызывать патологии.

Мир разделился в оценке регулирования ИИ

Авторы отчета указывают, что за последний год возникла активная дискуссия о потенциальных угрозах искусственного интеллекта и методах противостояния им. Однако пока на уровне государств и самой индустрии нет значительного прогресса из-за множества внутренних разногласий. На данном этапе эксперты выделяют три основных подхода государственного регулирования: проинновационный, жесткий и гибридный.

Проинновационный подход

Этого подхода придерживаются Великобритания и Индия. Он основан на том, что внедрение ИИ в настоящее время не требует принятия дополнительных законов. В Индии уверены, что любые текущие риски могут нивелироваться действующими отраслевыми правилами и законодательством о конфиденциальности. Великобритания включила некоторые принципы ИИ — ответственности, доступности и прозрачности систем — в свою политику и создала рабочую группу, занимающуюся вопросами безопасности передовых моделей, а также заключила специальное соглашение с DeepMind, Anthropic и OpenAI, чтобы получить ранний доступ к их моделям для понимания рисков.

Жесткий подход

Второго подхода придерживаются страны ЕС и Китай, которые выступают за разработку нового законодательства с особенно строгими мерами. Так, закон ЕС об искусственном интеллекте обязывает разработчиков информировать о рисках ИИ, раскрывать информацию о сгенерированном контенте, а также о данных обучения, защищенных авторским правом. Китай же принял ряд законов о рекомендательных системах, а также правила генеративного искусственного интеллекта, разработчики которого должны будут регистрировать свои алгоритмы в специальном реестре. Цель принятых законов — не препятствовать развитию технологии, а найти баланс между поддержкой отрасли и возможными последствиями развития ИИ. Так, компании обяжут проходить проверки безопасности ИИ перед выпуском систем и помечать генерируемый контент.

Гибкий подход

Наконец, США, Канада и некоторые другие страны выступают за гибридный подход с упором на добровольные обязательства разработчиков и принятие лишь точечных законов. При этом отдельные штаты США стремятся ввести более строгие законы об ИИ. Канада же намерена утвердить упрощенную версию закона ЕС об искусственном интеллекте, запрещая определенные приложения и регулируя другие.

Государства и организации также начинают сотрудничать в вопросах регулирования ИИ. Так, G7 создаст «Хиросимский процесс искусственного интеллекта» в сотрудничестве с Организацией экономического сотрудничества и развития (ОЭСР), который сформулирует «коллективный подход» к генеративному ИИ. ООН открыла консультацию для выработки рекомендаций в преддверии «Саммита будущего» 2024 года, который организует ООН для обсуждения последствий внедрения новых технологий. Anthropic, Google, OpenAI и Microsoft запустили Frontier Model Forum — орган, призванный содействовать ответственному развитию ИИ и обмену знаниями с политиками.

Сообщество ИИ предлагает первые решения

По словам авторов отчета, временный вакуум, возникший в вопросе регулирования ИИ, пока пытаются заполнить сами компании и исследователи. Так, ученые из Университета Мэриленда предлагают новую технику нанесения водяных знаков на сгенерированные тексты. Они уже разрабатывают соответствующий алгоритм с открытым исходным кодом. А DeepMind запустила SynthID — инструмент, который встраивает цифровой водяной знак непосредственно в пиксели сгенерированного изображения. Все эти инструменты призваны разрешить непростую ситуацию с соблюдением авторских прав.

Кроме того, компании, разрабатывающие инструменты ИИ, уже предлагают своим коммерческим клиентам программы защиты от исков в суде, а также компенсации. Так уже поступили Microsoft, Adobe, OpenAI и другие.

ИИ повлияет на занятость

Эксперты прогнозируют, что ИИ повлияет на ряд чувствительных областей, включая выборы и занятость. Исследования ОЭСР и OpenAI показывают, что вскоре могут начаться массовые сокращения специалистов в таких сферах, как право, медицина и финансы. При этом ОЭСР предупредила, что около 27% всех рабочих мест в мире относятся к профессиям «высокого риска» из-за развития ИИ.

Сторонники пессимистичного подхода призывают разработчиков сместить акцент в обучении ИИ с автоматизации человеческих задач на прогнозирование для улучшения процесса принятия решений. Сторонники оптимистичного подхода же уверены, что ИИ можно использовать как средство повышения квалификации. Так, одно из исследований продемонстрировало, что консультанты, использующие GPT-4, значительно превзошли своих коллег в выполнении 18 различных задач, включая контакты с заказчиками и творческое письмо.

Дебаты об экзистенциальном риске ИИ стали острее

Споры о том, несет ли искусственный интеллект риск всему человечеству, впервые нашли широкий отклик в обществе и значительно активизировались. Однако и в этом случае сообщество пока не нашло единого ответа на вопрос, подчеркивают эксперты.

Между тем компании начали предлагать инструменты для разработки безопасного ИИ. Так, DeepMind выпустила набор для оценки потенциально опасных способностей стандартных моделей (например, возможности совершать киберпреступления и самораспространяться). А компания Anthropic выпустила новую Политику ответственного масштабирования, в которой обязуется остановить разработку ИИ, если сочтет собственные меры безопасности недостаточными. Наконец, OpenAI с выпуском GPT-3.5 предложила своим клиентам API модерации, которые будут фильтровать данные обучения модели.

Кроме того, исследователи изучают альтернативные методы обучения ИИ, чтобы решить проблему предвзятости и безопасности. Один из них — самовыравнивание. Нейросеть при обучении использует небольшой набор руководящих принципов, который направляет ее при ответах на вопросы, используя контекст.

Исследователи из Университета Сассекса, Нью-Йоркского университета, FAR AI, Northeastern и Anthropic предлагают включить обратную связь с людьми непосредственно при предварительном обучении моделей, чтобы снизить объем нежелательного контента.

Финальные прогнозы на 2024 год

В финале отчета аналитики Air Street Capital представили десять прогнозов для мира ИИ на ближайший год.

- В производстве фильмов голливудского уровня для создания визуальных эффектов начнет использоваться генеративный искусственный интеллект.

- Некоторые медиакомпании, занимающиеся генеративным искусственным интеллектом, попадут под преследование за неправомерное использование технологии во время избирательной кампании в США в 2024 году.

- Самообучающиеся ИИ-агенты смогут работать над сложными задачами — созданием игр, решением научных вопросов.

- Как минимум одна компания в сфере ИИ выйдет на IPO.

- Погоня за масштабированием генеративного ИИ приведет к тому, что на обучение одной большой модели будет тратиться более $1 млрд.

- Федеральная торговая комиссия США или регулятор Великобритании начнут расследовать сделку между Microsoft и OpenAI из-за нарушений условий конкуренции. IT-гигант вложил $10 млрд в работу стартапа и теперь интегрирует возможности ChatGPT в свои продукты.

- В глобальном регулировании ИИ не будет больших подвижек, за исключением того, что сами компании возьмут на себя определенные обязательства.

- Финансовые учреждения создадут долговые фонды GPU (графических процессоров), чтобы заменить ими венчурный капитал для финансирования вычислений. Такие фонды позволят передавать компаниям во временное пользование вычислительные мощности за определенную плату.

- Песня, сгенерированная искусственным интеллектом, попадет в десятку лучших хитов Billboard Hot 100 или Top Hits 2024 на Spotify.

- Из-за роста рабочей нагрузки и затрат на вывод данных крупная компания, занимающаяся искусственным интеллектом (например, OpenAI), приобретет компанию по производству чипов для нужд искусственного интеллекта.