Что случилось

Компания OpenAI представила FrontierScience — набор задач который показывает, насколько хорошо модели искусственного интеллекта (ИИ) справляются со сложными научными задачами по физике, химии и биологии на уровне экспертов. Тест состоит из двух частей. Первая — короткие задачи в олимпиадном формате. Вторая — более развернутые исследовательские вопросы, которые требуют последовательных рассуждений и приближены к реальной научной работе.

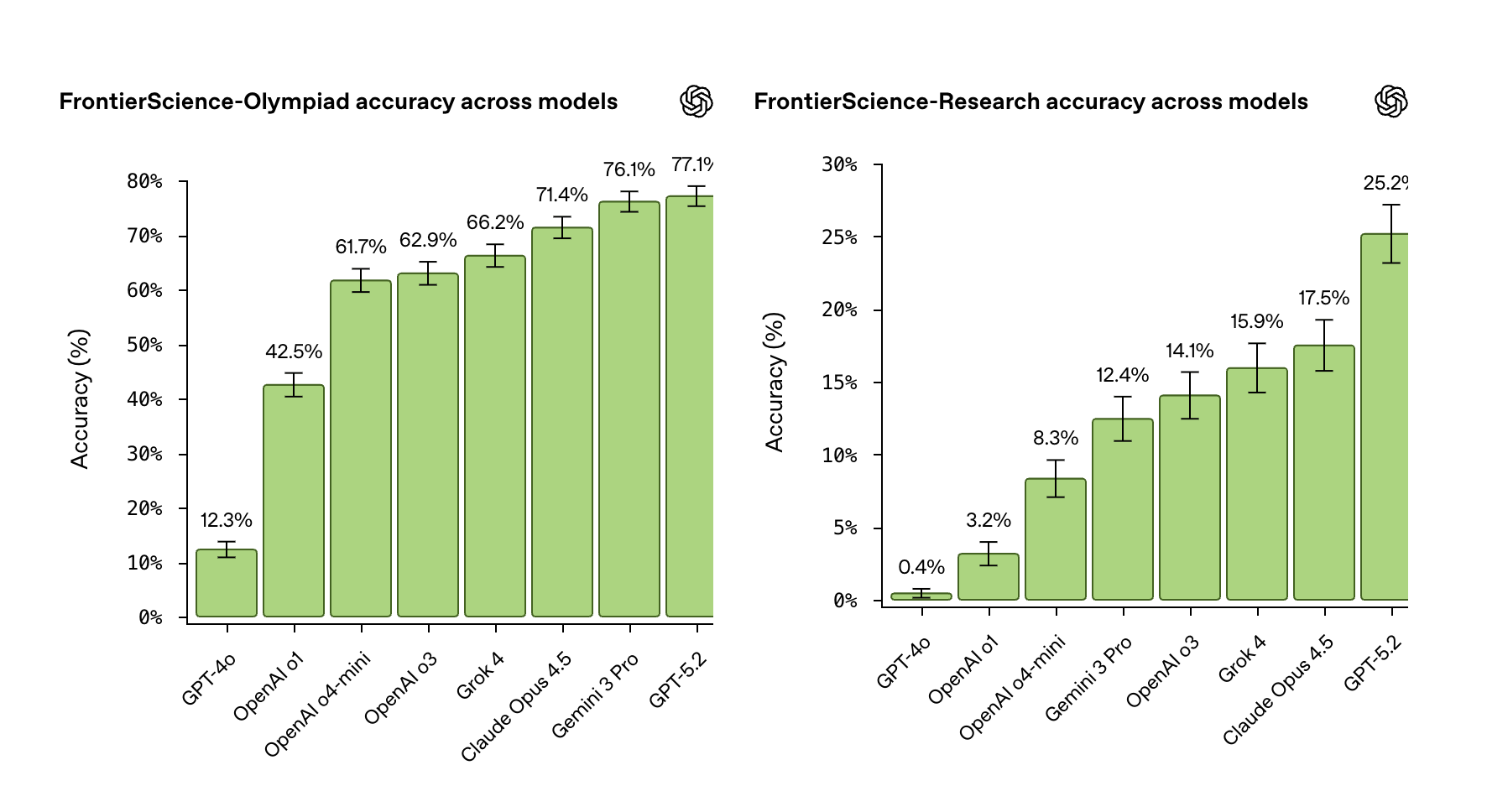

Полная версия FrontierScience включает более 700 текстовых заданий. Из них 160 считаются ключевыми для оценки способности модели: 100 олимпиадных и 60 исследовательских. Олимпиадную часть готовили 42 бывших призера международных олимпиад, а исследовательские задания — 45 специалистов, включая аспирантов и профессоров.

В исследовательской части задания оцениваются по шкале от 0 до 10 баллов, а не по принципу «верно или неверно». Каждый ответ проверяется по нескольким критериям — за каждый из них модель получает полный балл, половину или ноль. Ответ считается правильным при результате не ниже 7 баллов. Проверку выполняет отдельная модель GPT-5, которая сравнивает ответ с заранее заданными правилами и оценивает не только вывод, но и ход рассуждений.

По данным OpenAI, лучший результат показала модель GPT-5.2: 77% в олимпиадной части и 25% в исследовательской. Для сравнения: Gemini 3 Pro набрала 76% в олимпиадных заданиях, а в исследовательской — 12%.

Контекст и предпосылки

Бенчмарки — стандартизированные тесты, которые позволяют сравнивать разные модели между собой и с человеком. Такие тесты нужны, чтобы понять, где ИИ уже приближается к человеческому уровню, а где остаются ограничения.

Начиная с 2023 года разработчики начали отходить от простых тестов на знание фактов к более сложным проверкам рассуждений. Например, бенчмарк MMLU (Massive Multitask Language Understanding) включает более 15 тыс. вопросов по 57 предметам — от математики и физики до медицины и права. Современные модели показывают в нем результаты выше 80%, что сопоставимо с уровнем хорошо подготовленного студента.

Другой известный тест — BIG-bench от Google. Он состоит из более чем 200 нестандартных заданий, включая логические цепочки, абстрактные рассуждения и задачи без однозначного ответа. Этот бенчмарк выявил, что даже сильные модели часто ошибаются в многошаговых рассуждениях, несмотря на высокий уровень знаний.

Для оценки общего развития ИИ также используют адаптации человеческих IQ-тестов. Один из самых часто цитируемых примеров — Mensa Norway, открытый онлайн-тест, разработанный норвежским отделением Mensa. Он сфокусирован на абстрактном и логическом мышлении.

Помимо FrontierScience, существуют другие тесты, сосредоточенные именно на науку. Например, Humanity’s Last Exam проверяет способность нейросетей решать сложные вопросы по физике, химии и биологии, требующие глубоких рассуждений. Однако даже лучшие модели справляются лишь с частью таких заданий, заметно уступая людям.

Вероятные последствия

- FrontierScience — прозрачный инструмент, который показывает, в каких научных задачах нейросеть уже может помогать, а где ее использовать рискованно. Это снижает завышенные ожидания и упрощает принятие решений о том, можно ли доверять ИИ в исследовательской работе.

- Когда способности ИИ измеряются сложными и публичными тестами, разработчикам сложнее опираться на абстрактные формулировки вроде «уровень эксперта». Им приходится показывать конкретные результаты и объяснять ограничения моделей. Это может привести к более точному описанию возможностей ИИ.

- Результаты первичного теста FrontierScience показывают, что ИИ пока не заменяет ученых, а выступает вспомогательным инструментом. Это может снизить опасения о вытеснении исследователей и сместить обсуждение в сторону практических вопросов: как использовать ИИ для проверки гипотез, анализа данных и подготовки черновиков, не перекладывая на него ключевые решения.

➤ Подписывайтесь на телеграм-канал «РБК Трендов» — будьте в курсе последних тенденций в науке, бизнесе, обществе и технологиях.