О чем речь

В 2018 году в сети появилось видео, в котором Дональд Трамп призывает бельгийцев последовать примеру США и выйти из Парижского соглашения по климату. Однако ролик оказался фальшивкой. Его разместила Фламандская социалистическая партия, чтобы «привлечь внимание к необходимости действовать в связи с изменением климата».

Таких видео в интернете немало. В главных ролях — политики, музыканты или другие знаменитости, которые выступают с провокационными или комичными речами. Эти ролики называют дипфейками (англ. deepfake, «глубокий» + «фальшивка»), что дословно переводится как «глубокая фальшивка». Дело в том, что они сделаны с помощью глубокого обучение — по сути искусственного интеллекта — которое подменяет реальное изображение на сгенерированное, то есть ложное (отсюда и название).

Дипфейками могут быть не только видео, но и звуки, и фотографии. Этим умело пользуются мошенники. В 2019 году злоумышленники через искусственный интеллект сымитировали голос генерального директора одной британской энергетической компании. Сотрудники не заметили подлога и быстро исполнили просьбу руководителя — перевели $243 тыс. на венгерский счет для «оплаты услуг поставщика».

Однако дипфейки используются не только для махинаций и пранков над известными людьми.

Вечная жизнь — в цифре

В 2021 году сайт MyHeritage представил проект Deep Nostalgia. Его задача — «возвращение к жизни любимых предков». Пользователь загружает на сайт фотографию, которую с помощью алгоритмов превращают в короткую анимацию. Технологию разработала израильская фирма D-ID.

«Мы используем искусственный интеллект, чтобы вдохнуть новую жизнь в исторические фотографии; это помогает миллионам людей восстановить эмоциональную связь со своими предками и умершими близкими, — говорит генеральный директор MyHeritage Гилад Джафет. — Генеалогия — это история и защита наших семейных историй. Мы продолжаем показывать миру, насколько интересной и увлекательной она может быть».

В 2022 году компания пошла дальше и показал проект DeepStory — теперь к анимированным фотографиям можно добавить голосовое сопровождение. Пользователь добавляет текст, а алгоритмы преобразовывают его в речь. Затем искусственный интеллект реконструирует фотографию так, чтобы добиться синхронизации звука с движением губ.

Таким образом можно услышать истории журналистки Нелли Блай или фокусника Гарри Гудини, рассказанные от первого лица.

На службе у полиции

В 2003 году 13-летний Седар Соареш был застрелен в Роттердаме на парковке возле станции метро, когда играл с друзьями. Одно время считалось, что мальчика застрелил водитель, в которого тот бросал снежки. Однако расследование нидерландской полиции показало, что, скорее всего, Седар стал жертвой случайной пули в результате конфликта местных преступных группировок.

В мае 2022 году полиция опубликовало видео. В нем Седар смотрит в камеру, рядом — его семья и друзья. «Вы знаете больше? Тогда расскажите об этом», — обращается к зрителям мальчик. В последнем кадре появляются контакты полиции.

Полиция Нидерландов использовала дипфейк, чтобы записать обращение Седара. «Мы все лучше понимаем, как можно раскрыть старые дела, — сказано в пресс-релизе полиции. — Наука показывает, что личным призывом поделиться информацией можно поразить свидетелей и преступника в самое сердце. Что может быть сильнее, чем позволить Седару и его семье говорить за себя».

Через несколько дней после публикации видео полиция получила немало откликов, которые могут стать ключом к раскрытию дела.

Возвращение в молодость

Индустрия развлечений в целом и кино в частности стали самым очевидным местом для экспериментов с дипфейками.

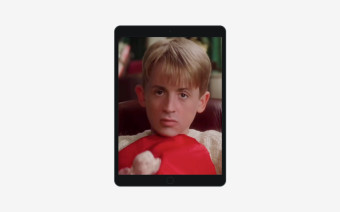

В финале второго сезона сериала «Мандалорец» фанатов «Звездных войн» ждал приятный сюрприз — на экране появился молодой Люк Скайуокер, хотя Марку Хэмиллу, сыгравшего рыцаря-джедая из оригинальных фильмов, на момент съемок было 70 лет.

За движения персонажа отвечал дублер, но в съемках принимал участие и сам Марк Хэмилл. Через специальный графический редактор специалисты по спецэффектам добились сглаживания кожи, а с помощью дипфейка получилось создать компьютерную композицию лица актера.

Однако не все оказались довольны результатом. Блогер Shamook доработал визуальные эффекты и опубликовал свой вариант на ютубе, его видео собрало несколько миллионов просмотров. Представители Lucasfilm оценили работу художника и наняли его в команду.

Разработка лекарств

Вывод лекарств на рынок может занимать годы, а стоимость разработки может достигать $2,8 млрд, а по некоторым оценкам и $4,5 млрд. При этом далеко не все исследования заканчиваются успехом — 90% клинических испытаний оказываются неудачными. Поиск новых действующих веществ — также долгий и дорогой процесс, но это может исправить искусственный интеллект.

Стартап Insilico представил платформу Pharma.AI, которая используют дифпейки для создания новых лекарств. Цели — обнаруживать новые мишени и соединения, а также упростить клинические испытания.

Командам Insilico и Университета Торонто потребовался 21 день, чтобы создать 30 тыс. дизайнов молекул, нацеленных на белок, вызывающий фиброз. Они синтезировали шесть из них в лаборатории, и четыре показали потенциальные перспективы в первоначальных испытаниях. В итоге сгенерированная искусственная молекула оказалась эффективной против целевого белка.

А что с правовым регулированием?

Дипфейки уже используются в медицине и индустрии развлечений, но им нашлось и более прозаичное применение — от фейкньюс и фальшивых порнофильмов до влияния на выборы. Поэтому общество все чаще ставит вопрос о регулировании распространения дифпейков

В ноябре 2022 года правительство Великобритании объявило, что планирует сделать незаконным распространение дипфейк-порно без согласия. Эта инициатива входит в Online Safety Bill — свод законов о безопасности в Сети.

Великобритания не единственная страна, в которой поднимались подобные вопросы. В США три штата — Вирджиния, Техас и Калифорния — ввели законы, регулирующие распространение дипфейков. В Вирджинии предусматривается уголовное наказание за распространение дипфейк-порно без согласия, а в Техасе запрещается создание и распространение дипфейковых видео, предназначенных для нанесения вреда кандидатам на государственные должности или оказания влияния на выборы.

Проблему осознают и коммерческие компании. В мае 2022 года Google запретил использовать свой сервис Colab для создания дипфейков, чтобы противостоять распространению порнографии.