РБК Тренды приводят перевод статьи The AI feedback loop: Researchers warn of «model collapse» as AI trains on AI-generated content, опубликованной на сайте издания VentureBeat.

ИИ в замешательстве

Создание контента при помощи нейросетей уже стало массовой практикой — так, половина сотрудников McKinsey применяют в своей работе инструменты генеративного ИИ, и эта тенденция только усиливается. Сегодня основная часть исходных данных, на которых обучаются нейросети, в основном создана людьми — это книги, статьи, фотографии и так далее. Но что произойдет, когда ИИ начнет обучаться на контенте, сгенерированном другим ИИ?

Группа исследователей из Великобритании и Канады опубликовала статью, в которой рассматривается именно этот вопрос. Их выводы неутешительны: использование для обучения ИИ данных, сгенерированных другими ИИ, приводит к необратимым дефектам в результирующих моделях.

Исследователи обратили особое внимание на вероятностные распределения для текстовых и генеративных моделей ИИ, генерирующих изображения. Выяснилось, что обучение на данных, произведенных другими моделями, вызывает «коллапс моделей» — дегенеративный процесс, при котором со временем модели забывают истинное распределение исходных данных. И происходит это довольно быстро.

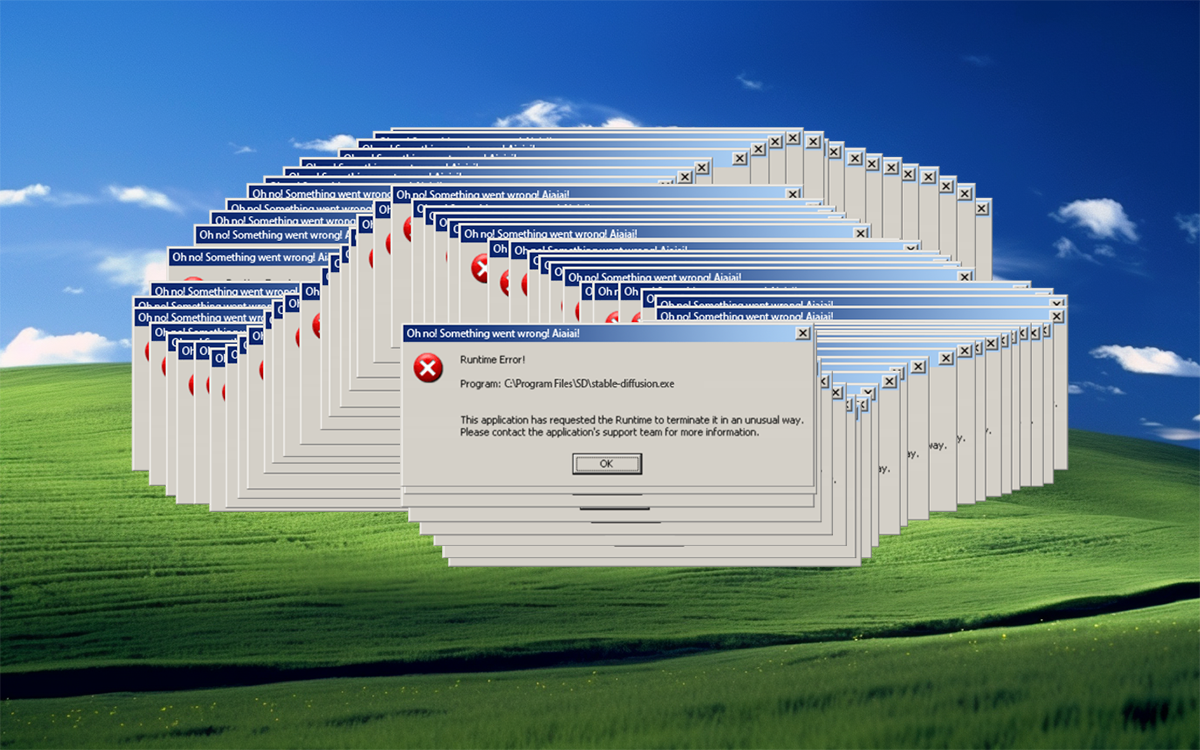

Постепенно ошибки в сгенерированных данных накапливаются, в результате чего модели, обучающиеся на таких данных, начинают еще больше искажать реальность. Это приводит к тому, что они все больше ошибаются в своих ответах и генерируемом контенте, а также производят все меньше неповторяющегося, непротиворечивого контента.

«Аналогично тому, как мы заполнили океаны пластиковым мусором и атмосферу углекислым газом, мы собираемся заполнить Интернет бессмысленной болтовней. Это усложнит обучение новых моделей путем парсинга веб-сайтов, давая преимущество компаниям, которые уже это сделали, или которые контролируют доступ к человеческим интерфейсам», — заявил один из авторов статьи, профессор безопасности инженерии в Кембриджском университете и Университете Эдинбурга Росс Андерсон.

Почему происходит коллапс

Проблему деградации качества ИИ можно сравнить с увеличением артефактов при многократном копировании изображения в формате JPEG. В качестве другой аналогии можно привести комедию 1996 года «Множество», в которой главный герой клонирует себя, а затем клонирует клонов, что приводит к экспоненциальному снижению уровня интеллекта у каждого нового клона

Коллапс моделей происходит, когда данные, сгенерированные моделями ИИ, загрязняют тренировочный набор для последующих моделей. «Оригинальные антропогенные данные лучше отражают реальный мир, поскольку содержат, в том числе, неправдоподобную информацию, — объяснил Илья Шумайлов, один из авторов работы, — генеративные модели, однако, имеют тенденцию к переобучению на популярных данных и часто неправильно понимают или интерпретируют менее популярные».

Если модель обучается на дата-сете c 10 изображениями синих котов и 90 желтых, ИИ запоминает, что желтые коты преобладают и показывает даже синих котов желтоватыми, а на запрос о новых данных выдает зеленых котов. С последующими циклами синий и вовсе заменяется зеленоватым, затем переходя в желтый.

«Загрязнение» данными, сгенерированными ИИ, приводит к искажению восприятия реальности моделями. Даже когда исследователи обучали модели не создавать слишком много повторяющихся ответов, они обнаружили, что коллапс все равно происходит, поскольку ИИ начинает выдавать ошибочные ответы, чтобы избежать частого повторения данных.

Как решить проблему

Исследователи выделили два пути, которые позволяют избежать коллапса модели.

Первый — сохранение оригинального дата-сета, полностью или в основном созданного людьми, и предотвращение его смешивания с данными от ИИ. В этом случае модель можно периодически переобучать на этих данных или полностью обновлять с их использованием. Второй путь, который может уберечь от деградации в качестве ответов и сократить количество ошибок — повторное введение в обучение ИИ нового очищенного антропогенного дата-сета.

Исследователи отмечают, что это потребует создания некого механизма массовой маркировки или же усилий со стороны создателей контента или ИИ-компаний, которые позволят разделить данные от людей и машин. Также важно обеспечить справедливое представление менее популярной информации в датасете как с точки зрения количества, так качества и точного описания характеристик. Это серьезный вызов, поскольку модели сложно обучать на редких событиях.