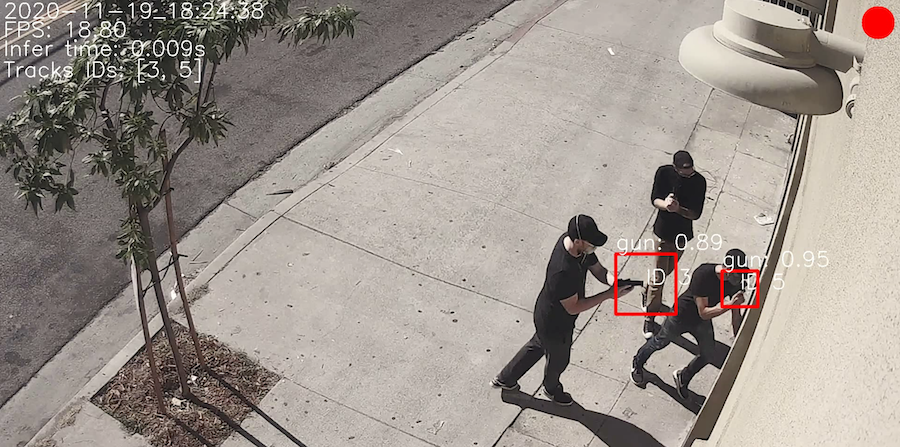

Способ 1. Выявлять угрозу через камеры наблюдения

Профессор компьютерных технологий из Вашингтонского университета Али Фархади утверждает: можно обучить искусственный интеллект выявлять признаки, что человек вооружен и намерен совершить шутинг или теракт. Такая система должна будет сканировать видеозаписи с камер в режиме реального времени. Если она обнаружит оружие в руках или сумке, то моментально подаст сигнал полиции или автоматически заблокирует преступнику вход в здание.

Некоторые организации уже внедрили похожие системы видеонаблюдения. Частная школа в штате Висконсин использует технологию от компании Actuate AI. Разработчики утверждают, что камеры обнаруживают оружие в течение 15 секунд и уведомляют полицию.

Главная проблема, которая может возникнуть, — ошибочное распознавание. Пока искусственный интеллект не обучится, он может принимать за оружие дрель, метлу и другие предметы. Недостаток света в помещении, ограниченный угол обзора и препятствия тоже негативно влияют на точность.

В России широко используются «умные» видеокамеры, которые идентифицируют личность человека, который может оказаться потенциальным преступником. В московских системах наблюдения используются нейросети от компании NtechLab. Они распознают лицо человека, сравнивая его внешность с фотографиями из базы. Если алгоритм считает, что выявил преступника, полиция получает уведомление с изображением, текущей локацией и личными данными.

Предлагаются и системы видеонаблюдения, распознающие оружие.

Способ 2. Анализировать посты в социальных сетях

Перед тем как совершить теракт, почти 60% преступников публикуют записи об этом в своих профилях в социальных сетях. Например, устроивший стрельбу в казанской школе Ильназ Галявиев за несколько дней до этого создал Telegram-канал, где написал, что нападет на гимназию, после чего совершит самоубийство.

Если вовремя выявлять такие посты и личность их автора, можно успевать предотвращать преступления. Искусственный интеллект подходит для этой задачи, потому что способен быстро перерабатывать большие объемы информации.

Психолог Алисса МакКейб и профессор компьютерных технологий Анна Румшиски из Массачусетского университета проанализировали 185 тыс. слов, которые использовали в своих постах в социальных сетях будущие террористы и выяснили, что склонные к насилию люди часто употребляют в своих записях слова «ненавижу», «они», «ты», редко — «мир», «люди», «время». Используя эти данные, можно создать шаблоны текстов, которые пишут преступники. Искусственный интеллект будет выявлять угрозы, сравнивая записи пользователей с обобщенными образцами.

Некоторые активисты предлагают анализировать не только публичные записи, но и сообщения в приватных диалогах. Например, детский благотворительный фонд NSPCC призвал Facebook (соцсеть принадлежит Meta Platforms Inc., признана экстремистской и запрещена в России) автоматически проверять личные чаты на информацию, которая может указывать на жестокое обращение с детьми.

Главная сложность анализа публикаций — необходимость отличать посты тех, кто просто агрессивен, и тех, кто на самом деле собирается совершить преступление. Согласно отчету от Управления ООН по борьбе с терроризмом, сейчас над решением этой проблемы работают несколько стартапов.

Кроме того, если в соцсетях начнут использовать механизмы проверки приватных чатов, а не публичных постов, то пользователи могут воспринять это как нарушение приватности. Зимой 2021 года, когда пользователи WhatsApp ошибочно решили, что после обновления политики конфиденциальности сервис будет передавать их данные в Facebook, мессенджер стал терять аудиторию.

Ученые из Института Алана Тьюринга считают, что еще одна проблема — определить, как должна действовать система правосудия, если прогноз системы окажется верным и полиция сможет предотвратить преступление: ведь фактически оно не будет совершено, поэтому наказывать виновника не за что.

Способ 3. Выявлять риски с помощью психологических опросов

У преступников, действия которых связаны с насилием, признаки агрессивного поведения проявлялись задолго до трагедий. Американский психолог Питер Лангман считает, что стрелков, напавших на школы, можно разделить на две категории. Одни из них были психопатами — людьми, получающими удовольствие от жестокости и обладающими низкой способностью к сопереживанию. Другие пошли на преступление из желания отомстить обидчикам, которые издевались над ними.

Исследователи медицинского центра в Цинциннати планируют разработать психологический тест из 28 вопросов. Он должен выявлять школьников, склонных к жестокости, и тех, кто терпит издевательства со стороны ровесников. Роль искусственного интеллекта здесь сводится к анализу ответов и определению, кому из опрошенных нужна работа с психологом.

Для прогноза рисков разработали шкалу краткой оценки агрессии у детей и подростков. Она основана на HCR-20 — методах прогнозирования насилия в криминалистике. Ичжао Ни, один из ведущих исследователей проекта, сообщает, что система будет вспомогательным инструментом в психотерапии и не заменит настоящего психиатра.

Способ 4. Управлять оружием

Селмер Брингсьорд, эксперт в области искусственного интеллекта, предложил создать «этичное оружие», из которого будет технически невозможно открыть огонь без необходимости. Брингсьорд и его команда разработали симулятор пистолета, обладающего искусственным интеллектом. Модель может за 2,3 секунды проанализировать окружающую обстановку и определить, стоит выстрелить или нет.

Главная проблема — правильность решений искусственного интеллекта. Брингсьорд намерен разработать устройства, которые будут действовать на основе законодательства. Но пока система не обучится, она может ошибочно блокировать выстрелы и создать угрозу для человека, который с помощью оружия защищает себя или других людей.